Les Pipelines de Reconnaissance Faciale à la Périphérie Fournissent des Décisions de 15–40 ms et 30–120 FPS en 2026

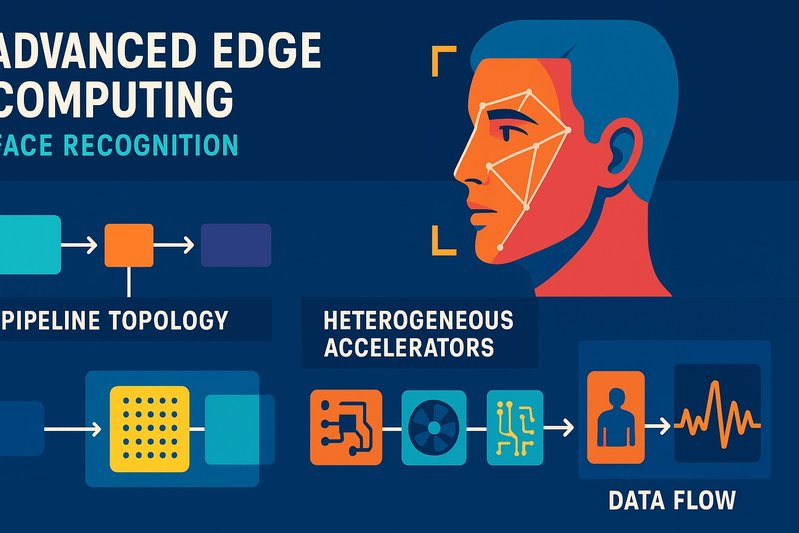

Une nouvelle génération de pipelines de reconnaissance faciale axés sur la périphérie effectue des décisions en 15–40 ms tout en soutenant 30–120 FPS par flux de caméra, redéfinissant le sens de “temps réel” sur le site de capture. Le changement est motivé par une boucle d’ingénierie serrée: une topologie de pipeline raffinée du décodage à la décision, une répartition délibérée des charges de travail sur des accélérateurs hétérogènes, des stratégies de compression qui maintiennent l’exactitude en FP16/INT8, et une recherche de voisins les plus proches approximée (ANN) optimisée pour la localité de cache et de mémoire. En parallèle, les conceptions hybrides qui conservent les embeddings à la périphérie et fragmentent la recherche vectorielle dans le cloud maintiennent aujourd’hui des seuils de latence stricts au sein d’un seul aller-retour WAN.

Cet article explique comment ces systèmes sont construits et optimisés. Vous verrez le pipeline divisé par étape et architecture; les choix de détecteurs et de reconnaisseurs fonctionnant sur du matériel de périphérie; comment la quantification, l’élagage et la distillation réduisent la latence sans compromettre l’exactitude; où exécuter quoi sur GPU/NPU/TPU/DSP; comment HNSW, IVF-PQ, et ScaNN se positionnent; et comment atteindre les objectifs de débit tout en contrôlant le budget énergétique. Nous couvrirons également la conception de la mémoire d’index, les pièges des démarrages à froid, et les tactiques que les équipes utilisent pour garder les décisions réactives.

Détails d’Architecture/Implémentation

Topologie du pipeline: de la capture à la décision

Les pipelines à la périphérie convergent vers une topologie commune optimisée pour une faible latence et un débit soutenu:

- Capture et décodage: le décodage matériel via les blocs ISP/encodeur maintient une faible charge CPU et alimente les images dans le pipeline avec un tampon minimal.

- Détection et alignement: des détecteurs modernes tels que RetinaFace et des variantes de YOLO adaptées aux visages fournissent une détection robuste à travers la pose et l’occlusion, suivies de l’alignement pour stabiliser les embeddings en aval.

- Inférence d’embeddings: les reconnaisseurs basés sur la marge—ArcFace, MagFace, CosFace—génèrent des embeddings 112×112 avec un haut pouvoir discriminant; les embeddings de qualité MagFace permettent un ajustement dynamique des seuils et une normalisation des scores pour des performances en ensemble ouvert sous des qualités de capture variables.

- Recherche ANN et prise de décision: une recherche vectorielle locale ou hébergée dans le cloud retourne les candidats top-k; la prise de décision applique des seuils ajustés pour le FAR/FRR désiré, avec une détection d’attaques de présentation (PAD) optionnelle là où nécessaire.

flowchart TD

A[Capture et Décodage] --> B[Détection et Alignement]

B --> C[Inférence d'embeddings]

C --> D[Recherche ANN et Prise de décision]Topologie du pipeline illustrant le flux de la capture des images à la prise de décision, mettant en évidence les processus clés et les optimisations pour une faible latence et un débit constant.

La détection optimisée pour la périphérie et l’embedding exécutent généralement en 10–25 ms sur des NPUs/GPUs capables, avec une recherche ANN locale ajoutant environ 0,5–5 ms pour des galeries de 100k ou moins lorsqu’elle est optimisée avec HNSW ou IVF-PQ. Cela donne des plages de capture à décision d’environ 15–40 ms pour des cadres 720p/1080p avec un seul visage, excluant la vivacité si elle n’est pas activée.

Budgets de latence par architecture

- Sur l’appareil et près de la périphérie: garder toute la boucle locale évite complètement la WAN. La proximité périphérique ajoute environ 1–2 ms sur LAN. En état de fonctionnement, 15–40 ms par décision est typique à charge de visage unique.

- Hybride: la périphérie effectue la détection/l’embedding, le cloud gère la recherche vectorielle. Ajoutez un aller-retour WAN—souvent 10–80 ms dans les environnements Wi-Fi/5G eMBB commerciaux—plus la recherche ANN dans le cloud (souvent 2–15 ms sur FAISS soutenu par GPU), et le surcoût léger du courtier. Le temps total de bout en bout se situe autour de 30–120 ms, dépendant du RTT et de la localité du cache.

- Uni…