Ingestion C2PA à Staydown Perceptuel: Ingénierie des Pipelines de Modération pour Images Sexuelles Générées par IA à Grande Échelle

Les régulateurs mondiaux ont tracé une ligne nette autour des images explicites générées par IA et des images intimes non consenties (NCII): d’énormes amendes, des audits formels et des attentes de retrait rapide définissent désormais la manière dont les plateformes doivent se construire. Avec des pénalités pouvant atteindre des pourcentages à deux chiffres du chiffre d’affaires mondial et des obligations de transparence allant de la provenance à l’étiquetage et aux appels, la pile technologique n’est plus une simple plomberie optionnelle: elle est devenue la surface de conformité.

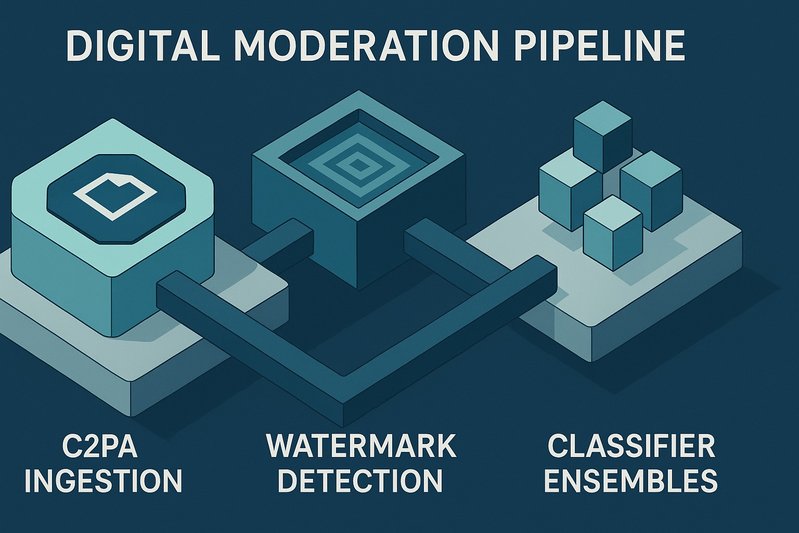

Ce plan détaille comment architecturer un pipeline de modération en production pour le contenu sexuel généré par IA et les NCIIs, de l’ingestion de manifestes C2PA et la détection robuste de filigranes aux ensembles de classificateurs, hachage perceptuel pour le “staydown”, et vérification de l’âge/consentement sous des contraintes strictes de confidentialité. L’objectif: montrer comment fusionner provenance, détection, hachage et vérification en un système décisionnel, conscient des juridictions, avec des journaux prêts pour les audits, une exposition minimale aux données sensibles, et des contrôles opérationnels qui résistent aux régulateurs comme aux équipes de sécurité rouge.

Les lecteurs apprendront: une topologie pragmatique de bout en bout; comment propager les attestations de contenu à travers le transcodage; comment concevoir des scores de confiance pour la fusion de classificateurs et de filigranes; ce que le staydown ciblé implique; et comment intégrer la vérification d’âge, d’identité et de consentement tout en répondant aux attentes de confidentialité par conception et aux obligations interrégionales.

Détails de l’Architecture/Implémentation

Topologie de pipeline de bout en bout

Un pipeline de modération résilient sépare l’ingestion, l’analyse, la prise de décision et l’application tout en garantissant des barrières de confidentialité et une auditabilité:

- Ingestion des téléchargements: Un service en périphérie accepte les images/vidéos, extrait tout manifeste C2PA, calcule les sommes de contrôle initiales et oriente vers le graphe de traitement. Il doit prendre en charge les rapports utilisateur et les entrées de signaleurs de confiance faisant référence à du contenu existant ou des URLs.

- Graphe de traitement: Un DAG à sortie multiple s’exécute en parallèle:

- Couche de provenance: Vérification du manifeste C2PA; validation des attestations et des signatures; extraction de la chaîne de garde.

- Détection robuste de filigranes: Plusieurs détecteurs pour le filigranage à la pointe de la technologie et les signaux de détectabilité GPAI.

- Ensemble de classificateurs: Modèles NCII et deepfake sexuels ainsi que des fonctionnalités de contexte/risque. Le routage de la révision humaine pour les cas limites est intégré par conception.

- Hachage perceptuel: Familles de hachages générées pour le staydown, ainsi que des flux de travail de correspondance de visage/identité uniquement lorsque cela est approprié et consenti.

- Services de décision: La logique de politique fusionne les sorties multi-signaux avec des drapeaux juridictionnels pour appliquer les décisions d’autorisation/étiquetage/restriction/suppression, et pour déclencher l’enregistrement de staydown.

- Files d’attente de modération: Files d’attente hiérarchisées pour la réponse d’urgence NCII, la révision du contenu adulte et les appels. Les résultats motivés et les déclarations de raisons sont enregistrés pour la transparence et la disponibilité à l’audit.

- Application et étiquetage: Étiquettes côté client pour le contenu généré/modifié par IA, géorepérées le cas échéant, associées à un flux de métadonnées qui persiste à travers les dérivés et les transcodes.

Cette séparation soutient des mesures proactives légales et proportionnées tout en évitant les approches de “contrôle général” interdites. Là où les services font face à l’examen le plus strict des risques et des audits, l’architecture doit également exposer des journaux de niveau artefact et des motivations de décision pour des audits indépendants périodiques.

Ingestion des manifestes C2PA et validation des attestations

Les plateformes rencontrent de plus en plus de contenu avec des attestations de provenance. Le service d’ingestion doit:

- Analyser les manifestes C2PA lors du téléchargement; vérifier les signatures, les chaînes de certificats et les preuves de falsification.

- Extraire la déclaration de modèle (par exemple, génération ou manipulation par IA déclarée) et lier ces faits au dossier interne de l’actif.

- Conserver un enregistrement de provenance normalisé, et le propager à travers le transcodage en intégrant les attestations dans les dérivés où techniquement faisable et autorisé par la politique.

- Exposer une API/SDK cohérente afin que les services en aval (rendu, partage, exportation) puissent lire et afficher la provenance et les étiquettes.

C2PA n’est pas universel, donc le système ne doit jamais traiter son absence comme une preuve d’authenticité. C’est un signal parmi d’autres, mais un signal puissant pour les divulgations et les pistes d’audit orientées utilisateur.

Détection robuste de filigranes et fusion des signaux

Les filigranes des fournisseurs de modèles et les mesures de détectabilité GPAI sont désormais attendus. Une mise en œuvre pratique nécessite:

- Plusieurs détecteurs: Exécuter des détecteurs divers pour atténuer la dérive fournisseur/modèle. Considérer la détection comme probabiliste, non binaire.

- Robustesse aux transformations: Évaluer les détecteurs sur les transformations communes (redimensionnement, recadrage, recompression); métriques spécifiques indisponibles.

- Fusion avec empreintes de modèle et classificateurs: Combiner la probabilité de filigrane avec les sorties de classificateurs en ensemble et les divulgations de provenance pour produire un score de confiance calibré.

- Résilience aux attaques: Inclure des vérifications pour les artefacts de suppression de filigrane, et orienter les cas suspects de faible confiance ou d’attaque vers une révision humaine.

Le scoring de confiance doit être monotone et explicable. Une rubrique transparente — par exemple, “divulgation de provenance + filigrane fort + consensus de classificateur” — aide à justifier les décisions et réduit les recours.

Ensembles de classificateurs pour la détection NCII et deepfake sexuels

Les obligations de réduire les méfaits des deepfakes et NCII rendent la détection proactive proportionnée pour les services à haut risque. Choix d’ingénierie:

- Ensembles multi-têtes: Têtes séparées pour la nudité/le contexte sexuel, les indices de substitution de visage/manipulation, et les indicateurs NCII. Éviter la dépendance à un seul modèle.

- Équilibrage précision/rappel: Ajuster par file d’attente. Les files d’attente d’urgence NCII peuvent tolérer plus de faux positifs pour maximiser la protection des victimes, tandis que les flux généraux nécessitent une précision plus stricte. Mètres spécifiques indisponibles.

- Intervention humaine: Mandater la révision pour les scores limites, les cas de figures publiques, et les signaux conflictuels. Maintenir des canaux d’authentification des victimes qui peuvent autoriser la correspondance de visage pour les retraits/staydown.

- Documentation et audits: Enregistrer les sources d’entraînement, les seuils, et les procédures de calibration pour étayer les déclarations sur l’efficacité.

Hachage perceptuel pour staydown ciblé

Le staydown ciblé — bloquant les ré-téléchargements de la même image/vidéo jugée illégale — est fondamental pour la réponse NCII.

- Familles de hachages: Générer plusieurs hachages perceptuels (par exemple, empreintes digitales robustes d’image/vidéo) par actif pour équilibrer les risques de collision et d’évasion; algorithmes et métriques spécifiques indisponibles.

- Portails d’adjudication: Seul le matériel retiré comme illégal ou violant la politique après une procédure régulière entre dans l’index de staydown.

- Juridiction et géorepérage: Appliquer le staydown régionalement lorsque la légalité diffère par pays ou état et lorsque les divulgations ou fenêtres de retrait sont spécifiques à la juridiction.

- Confidentialité et minimisation: Stocker des hachages et des métadonnées minimales, pas les vecteurs biométriques sous-jacents à moins que strictement nécessaire et consenti. Appliquer des calendriers de suppression alignés sur les politiques de rétention.

Tableaux de Comparaison

Outils de détection et d’authenticité en un coup d’œil

| Technique | Objectif principal | Atouts | Limitations | Meilleure utilisation dans le pipeline |

|---|---|---|---|---|

| Attestations de contenu C2PA | Vérifier la provenance; divulguer la génération/manipulation par IA | Vérifiable cryptographiquement; divulgations lisibles par l’homme; résiste à de nombreuses transformations lorsqu’il est propagé | Pas universellement présent; dépend du soutien de l’écosystème | Vérification d’ingestion; étiquettes face utilisateur; piste d’audit |

| Filigranes robustes / détectabilité GPAI | Signaler une origine générée par IA | Faible surcharge en inférence; complète la provenance | Vulnérable aux suppressions ou modifications lourdes; détection probabiliste | Étape de détecteur parallèle; fusionné dans les scores de confiance |

| Ensembles de classificateurs (NCII/deepfake) | Identifier contenu manipulé/explicite et risque NCII | Criblage proactif; seuils ajustables; humain-dans-la-boucle | Dérive dans le temps; entrées adversariales; nécessite une gouvernance | Graphe de traitement central; files d’attente et appels par niveaux de risque |

| Hachage perceptuel (staydown) | Empêcher les ré-téléchargements de contenu jugé | Efficace à grande échelle; évite la révision; peut être géorepéré | Collisions/évasions possibles; nécessite une adjudication prudente | Application post-décision; coordination inter-service |

Meilleures Pratiques

Vérification de l’âge, de l’identité et du consentement sans surcollecte

Les plateformes de contenu sexuel doivent combiner vérification de l’âge et contrôles de l’interprète/uploader tout en minimisant le traitement des données sensibles.

- Assurance de l’âge: Restreindre l’accès à la pornographie avec une vérification robuste de l’âge. Construire une interface agnostique au fournisseur pour permettre l’évolution des méthodes sans ré-architecturer.

- Identité et âge de l’interprète: Pour le contenu sexuellement explicite réel, vérifier les identités et âges des interprètes et maintenir des dossiers conformes et des avis de gardien de dossiers. Concevoir des flux de téléchargement qui séparent clairement le contenu purement synthétique du contenu réel pour éviter les mauvais étiquetages.

- Capture et révocation du consentement: Recueillir le consentement explicite des interprètes; fournir des voies de révocation et les lier aux files d’attente de modération pour une application rapide.

- Proportionnalité KYU/KYV: Appliquer la vérification en fonction du risque et du rôle (par exemple, téléchargeurs à haut risque). Minimiser les champs de données et mettre en œuvre un contrôle d’accès strict, le cryptage au repos et une rétention courte pour les artefacts sensibles.

Confidentialité par conception dans la modération

Dans toutes les régions, le traitement des données sexuelles et biométriques nécessite une base légale, de la transparence, de la minimisation et de la sécurité:

- Base légale et DPIAs: Documenter les bases légales et effectuer des évaluations d’impact sur la protection des données pour les traitements à haut risque (par exemple, correspondance faciale, classification de contenu sensible).

- Minimisation et suppression: Privilégier les hachages et les transformations basse résolution par rapport aux visages bruts. Établir des calendriers de suppression pour tous les artefacts, y compris hachages et télémétrie, alignés sur la limitation de la finalité.

- Contrôles d’accès et pistes d’audit: Appliquer des accès basés sur les rôles, des politiques de besoin de savoir, des journaux de décision immuables, et des registres de déclaration de raisons.

- Transferts internationaux: Utiliser des mécanismes de transfert approuvés pour le partage de signes transfrontaliers et garantir la résidence des données régionale lorsque requis.

Services d’étiquetage et de divulgation

La transparence face utilisateur n’est plus optionnelle pour les deepfakes et le contenu sexuel manipulé par IA.

- Étiquettes persistantes: Afficher des étiquettes visibles et contextuelles lorsque le contenu est généré ou manipulé par IA. Lier les étiquettes à l’actif et les propager à travers le partage, l’intégration et les flux de travail dérivés.

- Réduction du contexte et des dommages: Combiner les étiquettes avec une portée réduite pour les mineurs et des recommandations par défaut plus sûres dans les contextes à haut risque.

- Conformité géorepérée: Déclencher des étiquettes ou des divulgations lorsque des règles électorales ou des mandats spécifiques à une juridiction s’appliquent.

Architecture et drapeaux de caractéristiques interrégions

Une base de code globale doit se comporter différemment par région.

- Résidence des données: Diviser les indices (par exemple, hachages perceptuels, journaux d’audit) lorsque la résidence régionale est requise; concevoir une réplication minimale interrégionale.

- Drapeaux de caractéristiques conscients de la juridiction: Basculer les niveaux de criblage proactif, le texte des étiquettes, et les fenêtres de retrait par localité.

- Représentation et accès: Soutenir les demandes d’accès aux données des régulateurs tout en protégeant la confidentialité des utilisateurs via des journaux d’audit stricts et des exportations de données à portée limitée.

Observabilité, performance et intégrité des audits

- Budgets de latence: Fixer des budgets par étape afin que la détection et la décision de bout en bout puissent soutenir le retrait rapide et la conformité des avis de retrait; métriques de latence spécifiques indisponibles.

- Mise à l’échelle de la capacité: Mise à l’échelle automatique du DAG de traitement; utiliser la contre-pression et les files d’attente prioritaires pour les cas d’urgence NCII.

- Intégrité du journal d’audit: Chaîner cryptographiquement les journaux de décision lorsque c’est possible; conserver les déclarations structurées de raisons et de snapshots de preuves dans les limites de rétention.

- SLOs: Définir des SLOs pour le temps de retrait, la résolution des appels, et l’efficacité du staydown; surveiller continuellement la dérive dans les classificateurs et les détecteurs de filigrane.

Sécurité et Renforcement Contre les Abus 🛡️

Les adversaires vont supprimer les filigranes, perturber les classificateurs, et tenter de corrompre les indices de staydown. La réponse d’ingénierie allie prévention, détection et réponse.

- Contre-mesures de suppression de filigranes: Détecter les changements de distribution cohérents avec les recompressions/cadrages agressifs; fusionner avec d’autres signaux plutôt que de se fier uniquement aux filigranes.

- Tests adversariaux: Équipes rouges pipelines avec des attaques courantes (abus JPEG, reéchantillonnage, flou/brouillage, remasterisation basée sur GAN). Maintenir un registre des risques et des manuels spécifiques aux modèles.

- Surveillance de la dérive des modèles et des étiquettes: Suivre la précision/rappel sur des ensembles de validation curatés; déclencher des workflows de réentraînement et de recalibration. Benchmarks spécifiques indisponibles.

- Hygiène du staydown ciblé: Exiger une double révision avant d’ajouter à l’index de staydown; prendre en charge le déblocage réversible sur les appels réussis; maintenir des étiquettes de région pour respecter la légalité locale.

- Gouvernance des fournisseurs: Contrat pour documentation des modèles, support de filigranage, et APIs d’attestations de contenu. Exiger des attestations pour les fonctionnalités de détectabilité et les cadences de mise à jour.

- Réponse à la crise: Pré-définir les manuels d’incidents pour les campagnes NCII virales ou deepfake sexuelles, y compris les mesures de confinement, les chemins d’escalade, et les protocoles de communication avec les régulateurs.

Conclusion

L’ingénierie de la modération pour les images sexuelles générées par IA à grande échelle est désormais une discipline cruciale pour la conformité. Un système défendable fusionne la provenance (C2PA), la détection robuste de filigranes, les ensembles de classificateurs, et le hachage perceptuel en un pipeline multi-signal avec des politiques juridictionnelles conscientes, des décisions auditées et des contrôles de confidentialité par conception. Il exige aussi une vérification rigoureuse de l’âge/identité/consentement pour les téléchargements adultes, un étiquetage visible pour le contenu généré ou manipulé par IA, et un staydown ciblé qui empêche les ré-téléchargements une fois le contenu jugé. Les équipes qui réussiront traiteront cela comme un programme vivant: continuellement testé, mesuré et adapté aux directives et tactiques d’abus évolutives.

Points clés à retenir:

- Construire un graphe de traitement parallèle qui ingère la provenance, détecte des filigranes robustes et exécute des ensembles de classificateurs, alimentant une couche décisionnelle explicable.

- Utiliser le hachage perceptuel pour le staydown ciblé avec des portails d’adjudication stricts, un étiquetage régional, et une rétention de données minimale.

- Mettre en œuvre des workflows de vérification d’age/identité/consentement qui remplissent les obligations légales sans surcollecter des données sensibles.

- Appliquer la confidentialité par conception: bases légales, DPIAs, minimisation, contrôles d’accès, et calendriers de suppression à travers tous les artefacts.

- Renforcer contre les adversaires via des tests d’équipe rouge, la surveillance de la dérive, et la gouvernance des fournisseurs pour le filigranage et la détectabilité.

Prochaines étapes: inventorier vos signaux et lacunes actuels; mettre en place la vérification C2PA et la propagation des étiquettes; calibrer un ensemble et une étape de fusion de filigranes minimalement efficace; opérationnaliser un index de staydown ciblé; et réaliser un DPIA qui cartographie chaque artefact à une base légale, une rétention, et une politique d’accès. De là, itérer sur les métriques, les résultats d’équipe rouge, et les drapeaux spécifiques aux juridictions — parce qu’à l’horizon 2026, la détection “suffisante” ne suffira pas.