Agents Ambiants, Clouds Edge Attestés et Multimodalité Sur-Appareil Tracent les Deux Prochaines Années de l’IA Mobile

Une feuille de route pour les assistants préservant la vie privée, les modèles économes en énergie et les stacks adaptés régionalement

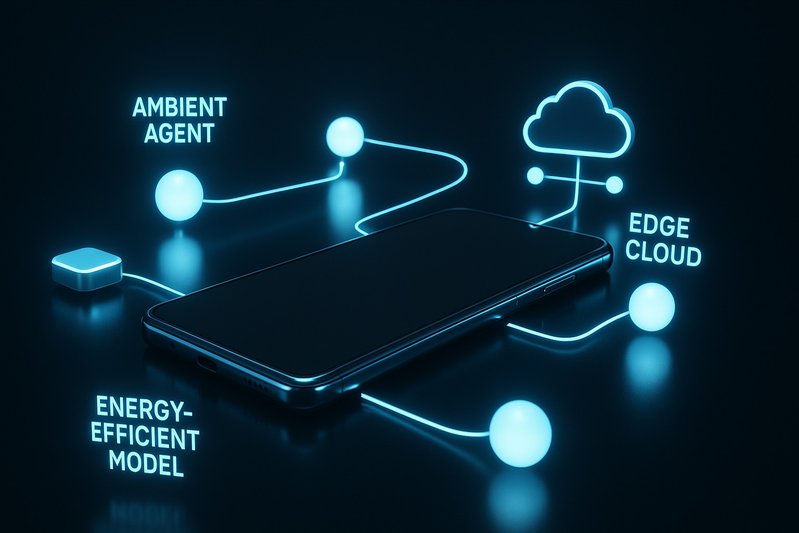

D’ici début 2026, l’IA des smartphones sera passée d’un simple ajout fonctionnel à une structure fondamentale—en particulier au niveau haut de gamme—transformant la manière dont les utilisateurs écrivent, traduisent, capturent et éditent sur le système. Les avancées les plus visibles sont matérielles: des assistants qui fonctionnent à travers les applications, des pipelines caméra et vidéo multimodaux, et une communication en temps réel qui tient même lorsque les réseaux ne le font pas. Ce qui distingue désormais les leaders n’est plus tellement « qui a de l’IA » mais plutôt « qui livre des expériences d’abord sur l’appareil dignes de confiance avec une couverture cohérente des applications par défaut, une posture claire sur la vie privée et un comportement énergétique prévisible ». Cet article présente la feuille de route de l’innovation qui définira les deux prochaines années: des agents ambiants avec un contexte persistant et des garanties de confidentialité, des clouds edge attestés pour un déchargement vérifiable au-delà d’une seule plateforme, une multimodalité sur-appareil visant à la compréhension vidéo en temps réel, et une conception centrée sur l’énergie ancrée par des NPU modernes. Les lecteurs apprendront quoi surveiller dans les APIs d’attestation, les trajectoires MLPerf Mobile, et les feuilles de route des NPU; quels schémas d’UI gagnent la confiance; comment les stacks régionaux divergent et convergent; et ce que les OEM doivent faire maintenant pour élargir la couverture des assistants sans épuiser la batterie ou l’adhésion des utilisateurs.

Percées en Recherche

De la fonction à la structure: des assistants qui agissent à travers les applications avec un contexte persistant et des garanties de confidentialité

Les assistants au niveau du système échappent aux applications cloisonnées et agissent là où les utilisateurs travaillent déjà. Apple Intelligence apporte des outils d’écriture—résumer, réécrire, corriger—en ligne à travers iOS, avec un Siri plus capable dans le contexte. Sur Android, Gemini est intégré à plusieurs niveaux, avec Gemini Nano propulsant les flux de travail sur appareil comme le résumé du Recorder et les réponses intelligentes sur Pixel 8 Pro. L’IA de Samsung Galaxy transforme les actions inter-applications en mémoire musculaire: Circle to Search fonctionne depuis n’importe quel écran, Live Translate couvre les appels et les conversations en personne, et Note/Transcript Assist rencontre les utilisateurs dans les applications par défaut au lieu de leur demander de copier-coller ou de basculer entre les applications.

flowchart LR;

A[Utilisateur] -->|utilise| B[Apple Intelligence]

A -->|utilise| C[Android Gemini]

B -->|fournit| D[Outils d'Écriture]

C -->|propulse| E[Flux de Travail sur Appareil]

B -->|interagit avec| F[Siri]

C -->|soutient| G[Réponses Intelligentes]

H[Galaxy AI] -->|permet| I[Circle to Search]

H -->|intègre| J[Live Translate]

H -->|soutient| K[Note/Transcript Assist]Ce diagramme de flux illustre les fonctionnalités interconnectées de divers systèmes d’IA et assistants à travers différentes plateformes, montrant comment les utilisateurs s’engagent avec ces technologies pour une productivité accrue et des interactions fluides.

Les signaux de confidentialité voyagent maintenant avec la capacité. Le modèle d’Apple prévaut: lorsque les tâches dépassent la capacité de l’appareil, Private Cloud Compute décharge vers des serveurs durcis vérifiables construits sur Silicon d’Apple, avec une attestation cryptographique et des engagements de transparence. Samsung ancre Galaxy AI dans sa plateforme Knox, associant des modes sur appareil pour des flux de travail sensibles avec des contrôles de niveau entreprise et un stockage de clés basé sur matériel. Google expose des invites et des paramètres clairs pour différencier la gestion sur appareil des fonctionnalités cloud et se défendre avec le sandboxing d’Android. Le schéma est clair: les assistants doivent être système et contextuels, mais leur succès sera jugé par la manière dont ils restent localement de manière prévisible—et comment ils le prouvent de manière crédible lorsque le cloud doit aider.

Asus souligne un fil adjacent: la valeur d’une capacité hors ligne robuste. Le Zenfone 12 Ultra intègre un Meta Llama 3‑8B sur appareil pour le résumé et positionne tous les outils développés par Asus—numérisation de documents, transcription, résumé d’articles—pour fonctionner localement, avec une option cloud pour les gros travaux. L’AI centrée sur le jeu du ROG Phone (X Sense, X Capture, AI Grabber) privilégie la reconnaissance sur appareil pour une faible latence. Cette posture d’abord locale réduit le risque quotidien d’erreurs de type « échec de fonctionnalité » dans les réseaux faibles tout en renforçant la confidentialité par défaut.

Standardisation de la confiance: déchargement attesté et calcul vérifiable au-delà d’une seule plateforme

Le déchargement vérifiable et respectueux de la vie privée est désormais un différenciateur compétitif, pas une simple case à cocher. Private Cloud Compute d’Apple a établi un plan de garantie élevé: exécution hors appareil dans des environnements scellés et attestables sur du matériel contrôlé par le fournisseur. Samsung et Google décrivent des défauts robustes sur appareil et des contrôles UX clairs pour lorsque le réseau ou les données de compte circulent. Les deux prochaines années devraient pousser le calcul attesté au-delà d’une seule plateforme, avec des signaux au niveau API que toute application ou assistant peut interroger: quel modèle a été exécuté, où il a été exécuté, et sous quelle attestation. Attendez-vous à ce que les secteurs d’entreprise et réglementés exigent des attestations portables et des crochets politiques qui s’étendent aux systèmes d’exploitation. Le test ne sera pas l’étiquette marketing—ce sera de savoir si les utilisateurs et administrateurs peuvent vérifier, prédire et auditer comment les données quittent l’appareil, si jamais elles le font.

Multimodalité sur-appareil: vers une compréhension vidéo en temps réel et un raffinement génératif sur le silicium des appareils

Les caméras et les pipelines vidéo se transforment en moteurs sémantiques en temps réel. Pixel continue de mélanger les sémantiques côté appareil avec des éditions accélérées par le cloud comme Magic Editor et Video Boost, en fonction des contraintes fonctionnelles. Les fonctionnalités d’édition générative et assistive inter-applications de Samsung réduisent les étapes de la capture au polissage. Asus mise sur les flux de travail créatifs sur appareil avec AI Magic Fill, Unblur, et Portrait Video 2.0, plus AI Tracking pour stabiliser et concentrer l’action.

La trajectoire est vers une plus grande partie de cela se produisant en direct sur le silicium des appareils. Les NPU/APU modernes et les planificateurs, combinés à des bibliothèques d’opérateurs économes en énergie, déplacent confortablement les éditions d’images fixes, le résumé et la traduction sur appareil. La vidéo générative lourde reste un défi: les longues éditions peuvent être intensives en énergie et sont souvent différées vers des pipelines cloud. Mais la frontière évolue à mesure que le débit d’inférence côté appareil s’améliore et que les stacks logiciels co-programment ISP/NPU/GPU pour éviter les blocages. L’objectif pragmatique des prochains cycles: reconnaissance en temps réel et raffinement génératif léger localement, avec un déchargement attesté et transparent pour les quelques tâches qui dépassent encore les budgets thermiques et énergétiques.

Feuille de Route & Directions Futures

L’énergie comme contrainte de premier ordre: ce qui s’étend, ce qui attend

La batterie et les thermiques définissent le plafond pour l’IA mobile. Les benchmarks tels que MLPerf Mobile montrent des gains d’inférence de génération en génération en termes de débit et de latence, permettant des charges de travail interactives sur appareil qui nécessitaient auparavant le cloud. Les divulgations des vendeurs sur la capacité et l’efficacité des NPU, ainsi que des bibliothèques d’opérateurs optimisées, réduisent la consommation d’énergie par tâche. Le résultat vécu: les éditions d’images fixes, le résumé de texte et la traduction ont un impact modeste sur la batterie avec les siliciums haut de gamme récents, tandis que les longues éditions vidéo génératives restent coûteuses.

Que faire ensuite:

- D’abord sur appareil, avec un report intelligent: Gardez les tâches interactives courtes localement; mettez en file d’attente les tâches lourdes et non urgentes pour un déchargement attesté ou des fenêtres d’inactivité, branchées.

- Planificateurs de système qui traitent l’énergie comme une exigence produit: Coordonner les rafales ISP/NPU/GPU pour éviter les falaises thermiques qui dégradent l’IA en cours de tâche.

- Améliorations modèles/outils axés sur l’efficacité énergétique: Continuer à compresser la puissance par jeton, image et édition par des avancées logicielles et de planification, même lorsque les charges de travail complètes ne peuvent pas encore être locales.

L’étoile du nord est la cohérence. Les utilisateurs perçoivent la confiance autant par la stabilité de la latence et la régularité de la batterie que par la vitesse brute—et ils jugent la fiabilité par le fait que les fonctionnalités d’IA se terminent de manière prévisible dans des conditions de signal médiocres.

Jalons à suivre: trajectoires MLPerf Mobile, feuilles de route NPU, APIs d’attestation

Une liste de surveillance crédible inclut:

- Progrès de MLPerf Mobile: Suivez comment l’inférence de la classe appareil évolue sur les tâches de texte et de vision pour déduire ce qui peut passer sur appareil ensuite.

- Feuilles de route NPU: De nouvelles vagues de plateformes de classe Snapdragon 8 et Dimensity 9300 ancrent le rythme pour les fonctionnalités d’abord locales; les améliorations des capacités arrivent souvent en tandem avec des planificateurs plus efficaces.

- APIs d’attestation et de confidentialité: Surveillez les signaux au niveau du système d’exploitation qui indiquent aux utilisateurs et aux applications où une tâche a été exécutée et sous quelles garanties, en s’appuyant sur le standard fixé par Private Cloud Compute.

Divergence et convergence régionales: partenariats LLM locaux, conformité, portabilité transfrontalière

L’étendue des fonctionnalités atterrit de plus en plus partout, mais les back-ends diffèrent. L’HyperOS de Xiaomi intègre des fonctions d’assistant dans toute la caméra, la galerie et les utilitaires système avec un planificateur système optimisé pour l’efficacité, tandis que la pile caméra du Xiaomi 14 Ultra pousse la photographie computationnelle avec des options de qualité professionnelle. Le ColorOS d’Oppo intègre des aides à l’édition/effacement IA, à la transcription et au résumé, et des moteurs d’orchestration de ressources, et les assistants régionaux s’adaptent aux réglementations et attentes locales. Les versions du marché chinois intègrent souvent des services domestiques pour se conformer aux exigences locales, visant la parité dans les capacités visibles par les utilisateurs.

En Amérique du Nord, en Europe et au Japon, les attentes s’inclinent vers les histoires de confidentialité d’Apple/Google/Samsung, le polissage des applications par défaut, et les signaux conviviaux pour entreprises tels que Knox. La portabilité transfrontalière comptera davantage à mesure que les voyageurs et les utilisateurs multinationaux s’attendent à des garanties de confidentialité et de performance cohérentes lorsque les appareils sont en itinérance—un argument pour des attestations standardisées et des modes sur-appareil prévisibles quel que soit le marché. La convergence est la parité fonctionnelle sur les tâches communes comme réécriture/résumé, traduction, et éditions de photos; la divergence réside dans les garanties de confidentialité, les intégrations de services, et comment visiblement ces garanties sont communiquées.

Impact et Applications

Sécurité, fiabilité et explicabilité: schémas d’UI qui gagnent la confiance

La confiance se gagne par des choix de design que les utilisateurs peuvent ressentir:

- Limites claires: Les outils d’écriture en ligne sur iOS et Android rendent évident quand le traitement est sur appareil par opposition aux ressources cloud, avec des invites et paramètres qui expliquent les compromis.

- Modes par défaut sur appareil: Live Translate sur Samsung offre des chemins de traitement locaux; les résumés du Recorder de Pixel se terminent localement dans la plupart des cas, évitant les moments de « fonctionnalité échouée » en mauvaise connectivité.

- Déchargement attesté si nécessaire: Private Cloud Compute d’Apple indique explicitement quand une tâche quitte l’appareil et sous quelles protections, répondant à la norme pour les utilisateurs sensibles à la confidentialité et aux entreprises.

L’explicabilité dans l’IA mobile ne nécessite pas de citations denses; elle appelle à un comportement prévisible, un statut visible, et des résultats récupérables. Si une fonctionnalité ne peut pas se terminer localement, elle doit vous le dire, demander la permission de décharger, et retourner un résultat avec le même profil de latence prévisible. La confiance grandit lorsque les utilisateurs voient des temps d’achèvement cohérents, comprennent quelles données vont où, et peuvent se désinscrire sans perdre de fonctionnalité de base.

Mesurer ce qui compte ensuite: confiance perçue par l’utilisateur, stabilité de la latence, prévisibilité des échecs

La vitesse et la précision seules ne capturent plus la qualité de l’expérience utilisateur. Une lentille pratique est le cadre des « 5‑S »:

- Vitesse: Moins d’étapes et moins de basculement entre applications via l’assistance inter-application.

- Taux de réussite: La disponibilité hors ligne et la dégradation progressive réduisent les échecs dans les mauvais réseaux.

- Satisfaction: La couverture dans les applications par défaut stimule la découverte et l’habitude.

- Confiance en la sécurité: Les assurances architecturales—d’abord sur appareil, déchargement attesté—ancrent la confiance.

- Coût énergétique: Les tâches doivent s’inscrire dans les budgets quotidiens de batterie.

Pour affiner cette lentille, deux mesures complémentaires sont importantes:

- Stabilité de la latence: Pas seulement la vitesse médiane, mais la variance sous charge, signal faible, et stress thermique.

- Prévisibilité des échecs: États clairs lorsque une tâche réussira hors ligne par opposition à un report, et des solutions de secours intelligibles.

Les tests de batterie externes à travers des mélanges réalistes fournissent un contexte utile pour l’endurance sous l’utilisation de l’IA, bien que les chiffres spécifiques varient selon l’appareil et la charge de travail. L’objectif pour les deux prochaines années: faire en sorte que les résultats de l’IA soient aussi prévisibles que d’appuyer sur le déclencheur de l’appareil photo—rapides, cohérents, et avec des compromis connus.

Feuilles de route pour les OEMs: couverture plus profonde des applications par défaut, engagements de cycle de vie, ampleur de l’assistant

Les deux prochaines années récompenseront le souci du détail d’exécution:

- Élargir la couverture des applications par défaut: Mettez expliquer/traduire/résumer là où les utilisateurs vivent déjà—notes, clavier, appareil photo, téléphone, enregistreur—en reflétant comment l’IA Galaxy et les outils d’écriture systémiques d’Apple stimulent l’utilisation quotidienne.

- S’engager à être local d’abord: Prioriser sur appareil pour la voix sensible à la vie privée et le texte personnel; réserver le déchargement attesté pour les tâches lourdes, approuvées par l’utilisateur.

- Livrer des contrôles transparents: Faites des choix sur appareil vs cloud explicites et rappelables, avec des crochets de politique d’entreprise là où c’est pertinent.

- Accorder à des personas: Asus démontre le pouvoir d’une valeur ciblée—résumé sur appareil axé sur le créateur sur Zenfone et reconnaissance critique en latence pour le jeu sur ROG—tandis que des leaders comme Apple, Google et Samsung montrent la largeur. Choisissez un centre de gravité et exécutez profondément.

- Cycle de vie et stabilité: Des mises à jour soutenues qui améliorent les modèles et les planificateurs sur appareil après le lancement peuvent significativement augmenter la vitesse, la fiabilité, et l’énergie sans nouveau matériel.

Risques et points de rupture: erreurs de modèle, faux pas de confidentialité, et épuisement de la batterie

Trois lignes de faille testeront la maturité de l’IA mobile:

- Sorties incorrectes ou trop confiantes: Les systèmes génératifs peuvent produire des résultats erronés ou trompeurs; les taux spécifiques ne sont pas disponibles, donc concevoir pour la vérification et un retour en arrière facile.

- Lacunes de confidentialité dans le déchargement: Sans environnements attestés, contrôlés par le fournisseur et des divulgations claires, le traitement hors appareil érode la confiance—surtout dans les contextes réglementés.

- Batterie et thermiques: Les longues éditions vidéo génératives et d’autres tâches lourdes peuvent faire basculer les appareils vers un étranglement thermique ou une décharge visible; une UX pratique doit les acheminer vers le cloud ou des fenêtres inactives, avec un choix utilisateur explicite.

La voie résiliente consiste à garder les tâches interactives sur appareil, à communiquer quand et pourquoi le déchargement se produit, et à donner aux utilisateurs le contrôle sur les compromis batterie vs qualité.

Conclusion

La prochaine phase de l’IA mobile ne concerne pas l’invention en isolation; elle concerne l’intégration avec des garanties. Les assistants passent de fonctionnalités à une structure—présents dans n’importe quelle application, transportant le contexte, et restant locaux par défaut. Lorsque les appareils doivent aller chercher de la puissance supplémentaire, les clouds edge attestés montrent comment préserver la confidentialité sans interrompre le progrès. Les caméras et les pipelines vidéo continuent leur dérive vers la compréhension sémantique en temps réel sur appareil, délimités par les réalités énergétiques que les planificateurs intelligents et des NPU toujours meilleurs assouplissent progressivement. Les gagnants mesureront ce que les utilisateurs ressentent réellement—confiance, stabilité, et endurance—et concevront leurs feuilles de route autour de ces résultats.

Points clés à retenir:

- Les agents ambiants ont besoin d’un contexte persistant et des garanties explicites de confidentialité pour gagner la confiance quotidienne.

- Le déchargement attesté passe de différenciateur à attente; des APIs standardisées devraient suivre.

- La multimodalité sur appareil s’étendra dans le texte, l’image, et la vidéo court format; les éditions génératives lourdes restent candidates au cloud.

- L’énergie est le réactif limitant; concevoir pour une latence cohérente et une stabilité de batterie, pas seulement la vitesse de pointe.

- Les stacks régionaux convergeront sur les fonctionnalités mais divergeront dans les back-ends; la portabilité des signaux de confiance compte.

Prochaines étapes pour les constructeurs et acheteurs:

- Constructeurs: Prioriser la couverture des applications par défaut, des défauts sur appareil, et des contrôles transparents; investir dans les parcours d’attestation et l’optimisation des planificateurs; suivre les trajectoires de MLPerf Mobile et les feuilles de route des NPU pour planifier les évolutions de capacité.

- Acheteurs: Recherchez une architecture de confidentialité claire, des modes hors ligne fiables, et une latence cohérente dans des conditions réelles; évaluez l’ampleur de l’assistant là où vous travaillez réellement—notes, appareil photo, appels, et enregistreur.

En regardant vers l’avenir, surveillez trois cadrans: les trajectoires MLPerf Mobile pour ce qui reste sur appareil, les générations NPU pour la rapidité et l’efficacité, et les APIs d’attestation pour la sécurité du flux. Si ces cadrans bougent ensemble, les assistants ambiants et préservant la vie privée sembleront moins être une nouveauté et plus la manière par défaut dont les téléphones pensent et agissent. 🔋