La Arquitectura Híbrida de Borde–Nube Reduce los Costos de Ancho de Banda Biométrico por 100× Mientras Escala a Galerías de Millones de IDs

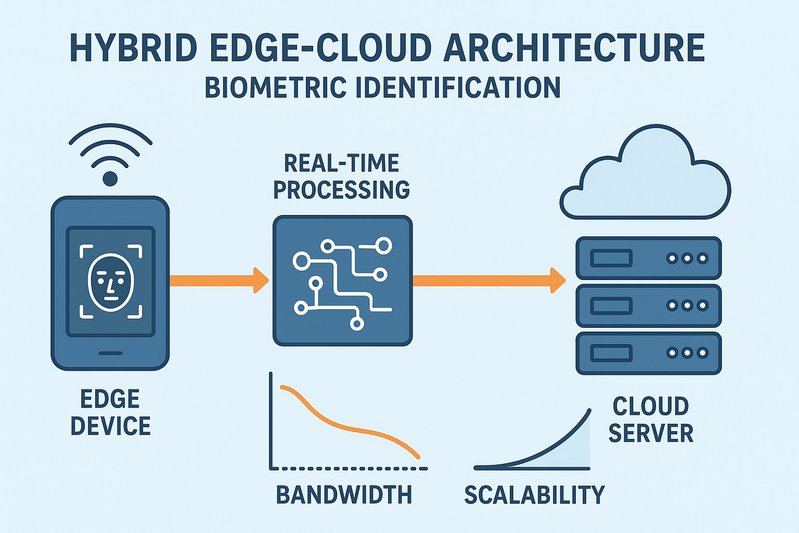

Megabits de video entran, kilobytes de datos salen—esa es la nueva matemática para la identificación biométrica en tiempo real a gran escala. A medida que las organizaciones llevan la identificación de pilotos a producción a través de flotas de cámaras en múltiples sitios, los mayores rubros no son chips o licencias; son el ancho de banda y el egreso en la nube. Las arquitecturas que mantienen la detección y el embedding en el borde, luego envían vectores compactos a la nube para búsquedas a gran escala, están reduciendo la transferencia de datos por órdenes de magnitud mientras preservan la capacidad de respuesta a nivel de milisegundos. Al mismo tiempo, las galerías de un millón de IDs y los análisis entre sitios están impulsando a los compradores hacia patrones híbridos que preservan la elasticidad sin comprometerse con un movimiento de datos punitivo continuo.

Este artículo presenta una visión apta para el CFO del costo total de propiedad (TCO), la economía del ancho de banda detrás de las reducciones de 100× y los puntos de equilibrio que separan las implementaciones edge-first, híbridas y solo en la nube. Los lectores aprenderán dónde se acumulan los costos por arquitectura, cómo se comparan las transmisiones continuas con los enlaces ascendentes de solo embedding, dónde vale la pena el híbrido para las listas de vigilancia a escala de millones, y cómo los marcos de gobernanza (GDPR/CCPA/BIPA) influyen en la decisión de implementación. Cierra con la segmentación de casos de uso, libros de jugadas de implementación, análisis de sensibilidad y una lista de verificación ejecutiva para seleccionar la arquitectura adecuada por tamaño de galería, concurrencia y política.

ROI y Factores de Costo por Arquitectura

CapEx vs OpEx elástico

- Los dispositivos con edge y las puertas de enlace cercanas al borde anticipan el gasto en CapEx de dispositivos, instalación y almacenamiento en las instalaciones. La recompensa aparece como un bajo OpEx continuo porque se minimizan el ancho de banda y el cómputo en la nube.

- Solo en la nube desplaza el gasto a OpEx elástico: horas de instancia de GPU/CPU, almacenamiento y egreso de datos. Se escala fácilmente para pilotos y cargas de trabajo intermitentes, pero se convierte en un gasto persistente bajo la ingestión 24/7 de sitios multicámara.

- El híbrido divide la diferencia: el borde realiza la detección/el embedding (y a menudo el reconocimiento de liveness), mientras que la nube ejecuta la búsqueda de vecinos más cercanos aproximados (ANN) a través de índices fragmentados. El OpEx sigue el volumen de consultas real en lugar de los marcos de video, y las facturas de ancho de banda se reducen por dos a tres órdenes de magnitud en comparación con el streaming.

flowchart TD

A[Arquitectura Edge] -->|Anticipar gasto| B[CapEx]

B -->|Conduce a bajo| C[OpEx]

D[Arquitectura Solo en Nube] -->|El gasto elástico pasa a| E[OpEx]

E -->|Puede volverse persistente bajo| F[Ingestión 24/7]

G[Arquitectura Híbrida] -->|Detección realizada en el Borde| H[La Nube realiza ANN]

H -->|OpEx ligado a| I[Reducción de costos de ancho de banda]Diagrama de flujo que ilustra el ROI y los factores de costo asociados con diferentes arquitecturas: Edge, Solo en Nube y Híbrida.

Elementos de línea de almacenamiento y egreso

- Un video continuo 1080p30 consume típicamente de 2 a 8 Mbps por transmisión dependiendo de la codificación. Con la transferencia de datos en la nube pública comúnmente cotizada por gigabyte, la captura continua basada en video puede convertir el egreso en un elemento de línea dominante y recurrente.

- El enlace ascendente de solo embedding transmite “cientos a unos pocos miles de bytes por consulta” en lugar de megabits por segundo. Incluso a altas tasas de decisión, esto reduce el movimiento de datos por dos a tres órdenes de magnitud, convirtiendo el egreso de uno de los tres principales elementos de línea en un gasto comparativamente pequeño.

- El almacenamiento local sigue siendo un factor de costo modesto para edge y near-edge, dominado por el tamaño del índice de la galería y las políticas de retención. En puertas de enlace de gama alta, las galerías prácticas en memoria alcanzan las cientos de miles de vectores; las galerías a escala de un millón desplazan la búsqueda a la nube.

Eficiencia operativa e implicaciones de SLA

- Los diseños centrados en edge minimizan las dependencias de WAN, manteniendo los SLAs ajustados al eliminar el mayor obstáculo: el tránsito de la red. Las organizaciones evitan los precipicios de rendimiento durante la congestión WAN, y las mesas de ayuda ven menos escaladas relacionadas con la conectividad.

- Solo en la nube centraliza la visibilidad y las actualizaciones pero es sensible a la variabilidad de jitter y backhaul; los SLAs deben absorber los viajes redondos de WAN y hacer cola bajo carga.

- El híbrido cumple con los SLAs con procesamiento en el borde más un viaje redondo de WAN, siempre que los puntos de presencia regionales y el almacenamiento en caché estén en su lugar.

Economía de Ancho de Banda y Modelos de Equilibrio

Video continuo vs enlace ascendente de solo embedding

- Transmitiendo 1080p30 a 2-8 Mbps por flujo impulsa una transferencia de datos sustancial y continua hacia la nube. Donde la transferencia de datos está facturada por gigabyte, estos flujos constantes se acumulan directamente en los cargos de egreso.

- El enlace ascendente de solo embedding es kilobytes por decisión—“cientos a unos pocos miles de bytes por consulta.” Esto reduce las cargas útiles por dos a tres órdenes de magnitud frente al video continuo, reduciendo enormemente el egreso continuo y haciendo que el costo por decisión sea más predecible. 📉

flowchart TD;

A[Transmisión de Video Continua] -->|2-8 Mbps/flujo| B[Transferencia de Datos Sustancial]

B -->|Conduce a| C[Altos Cargos de Egreso]

D[Enlace Ascedente de Solo Embedding] -->|Kilobytes/decisión| E[Transferencia de Datos Reducida]

E -->|Resulta en| F[Cargos de Egreso Menores]

F -->|Conduce a| G[Costos Predecibles]

H[Multi-Cámara Siempre Activa] -->|Sugiere| I[Soluciones Edge o Híbridas]

I -->|Reduce la Necesidad de| J[Backhaul de Video]

I -->|Mantiene| K[Gobernanza Centralizada]Diagrama de flujo que ilustra la economía del ancho de banda en la transmisión continua de video frente al enlace ascendente de solo embedding, y el impacto de soluciones multi-cámara siempre activas en comparación con la demanda intermitente. Muestra la relación entre las tasas de transferencia de datos, los costos y las soluciones para la gestión de video.

Multi-cámara siempre activa vs demanda intermitente y pilotos

- Los sitios siempre activos con muchos flujos inclinan la balanza hacia el edge o híbrido. Solo en el edge elimina el backhaul de video; el híbrido preserva la gobernanza central y la búsqueda a escala de millones mientras mantiene el enlace ascendente diminuto.

- La demanda intermitente o estacional favorece la elasticidad en la nube. Cuando las cámaras permanecen inactivas y los volúmenes de decisiones aumentan de manera impredecible, solo en la nube puede ser rentable—especialmente en los primeros pilotos—porque el cómputo se ajusta con el tráfico y el CapEx inicial sigue siendo bajo. Sin embargo, a medida que la utilización se acerca al estado estable, los costos de ancho de banda y egreso dominan y erosionan la ventaja.

Intuición simple de equilibrio

- Cuando una cámara funciona 24/7, cada Mbps duele. Reducir la transferencia por cámara de megabits por segundo a kilobytes por decisión es la forma más rápida de alcanzar la cordura del TCO. En la práctica, edge o híbrido generalmente ganan para sitios de flujo múltiple y constante; solo en la nube retiene una ventaja para pruebas de corta duración, iteraciones rápidas o programas de bajo ciclo de trabajo donde la ingesta continua es limitada.

- El cómputo no es el único determinante. La fiabilidad de la WAN, las restricciones de políticas y el tamaño del índice determinan dónde ocurre la búsqueda. Si la galería es pequeña y las políticas exigen minimización de datos, solo edge es convincente. Si la galería es muy grande o la desduplicación entre sitios importa, el híbrido añade eficiencia sin reintroducir el backhaul de video.

Estrategias de Escalamiento y Gobernanza

Galerías a escala de un millón de IDs empujan hacia híbrido o nube

- La RAM en el edge limita el tamaño del índice local. Las puertas de enlace de gama alta pueden contener aproximadamente de 100k a unos pocos cientos de miles de vectores en memoria dependiendo de la precisión y los metadatos. Superar un millón de identidades de manera confiable requiere índices ANN fragmentados en la nube.

- El híbrido mantiene los embeddings en el edge mientras la nube maneja la búsqueda en FAISS fragmentada o similar, con cachés regionales para identidades “calientes”. Esto mantiene cargas útiles pequeñas, evita el tránsito de video y mantiene decisiones de baja latencia con un viaje redondo de WAN.

- Solo en la nube también maneja galerías de millones a miles de millones de escalas pero reintroduce el costo en estado estable del streaming de recortes o cuadros e incrementa la exposición a los problemas de rendimiento de la WAN.

Riesgo, conformidad y gobernanza como variables de negocio

- La minimización de datos es una palanca de política, no solo una característica técnica. Mantener plantillas y decisiones en el dispositivo o enviar solo embeddings reduce el volumen de datos personales transmitidos o almacenados centralmente.

- GDPR enfatiza la necesidad y la proporcionalidad; CCPA/CPRA y BIPA imponen restricciones estrictas sobre los identificadores biométricos. Las arquitecturas que minimizan el flujo de datos y la retención simplifican las Evaluaciones de Impacto de Protección de Datos (DPIAs), reducen el radio de explosión de brechas y agilizan las operaciones de derechos de los sujetos.

- La detección de ataques de presentación (PAD) debe ser aplicada en el edge cuando sea posible para detener ataques antes de que los datos salgan del sitio, informada por estándares de prueba reconocidos. La gobernanza debe cubrir explícitamente la creación de listas de vigilancia, la retención, los controles de acceso, los registros de auditoría y el monitoreo de equidad.

Estrategias de adquisición y despliegue

- Implementar por fases: comenzar con en el dispositivo o cerca del edge en uno o dos sitios para fijar las bases de SLA y políticas. Agregar un punto de presencia regional y búsqueda en la nube para desduplicación entre sitios a medida que las galerías crecen.

- Aprovechar la regionalidad: posicionar índices en la nube por región para mantener los tiempos de ida y vuelta moderados; usar cachés de edge para identidades frecuentemente coincididas para amortizar la latencia de la WAN.

- Evaluación de proveedores: priorizar el soporte para la división edge-to-cloud (enlace ascendente de embedding), ANN fragmentado a escala, opciones de compresión de índice y herramientas de gobernanza de datos. Confirmar la alineación de políticas de egreso y la medición de ancho de banda transparente en contratos.

Segmentación de Casos de Uso y Lista de Verificación de Decisión

Control de acceso y seguridad en las instalaciones

- Prioridades: baja latencia, privacidad y galerías modestas.

- Arquitectura preferida: en el dispositivo o cerca del edge. Las decisiones se mantienen localmente, PAD se ejecuta en el dispositivo, y las plantillas se almacenan cifradas en reposo. El backhaul solo lleva alertas o resúmenes.

POS minorista y análisis de piso

- Prioridades: bajo sobrecarga de WAN, costo predecible, fusión a nivel de sitio en múltiples cámaras.

- Arquitectura preferida: near-edge con la opción de añadir búsqueda híbrida más tarde. Mantener el ancho de banda trivial durante los pilotos, luego expandir a la búsqueda fragmentada si las listas de vigilancia o la desduplicación entre tiendas se vuelven críticas para el negocio.

Nodos de transporte y sitios con restricciones de ancho de banda

- Prioridades: conectividad intermitente, resiliencia, ventanas de subida pequeñas.

- Arquitectura preferida: en el dispositivo con alertas de almacenar y enviar. Sincronizar periódicamente embeddings o listas de vigilancia cuando la conectividad lo permita.

Análisis a escala ciudadana y SOCs empresariales

- Prioridades: galerías a escala de millones, desduplicación entre sitios, gobernanza centralizada.

- Arquitectura preferida: híbrido con puntos de presencia regionales. El edge maneja la detección/embedding/PAD; la nube maneja ANN fragmentado, cumplimiento de políticas y análisis global mientras la ingestión permanece en kilobytes por decisión.

Comparación a simple vista de los impulsores de costos

| Arquitectura | Perfil de Ancho de Banda | Perfil de Cómputo | Escala de Galería | Pie de Gobernanza |

|---|---|---|---|---|

| En el dispositivo | Solo alertas/metadatos | NPUs/GPUs del dispositivo | Hasta ~100k–pocos cientos de k | Mínima transitación de datos; fuerte minimización de datos |

| Puerta de enlace cerca del borde | Solo alertas/metadatos | Nodo del sitio consolida flujos | Mayor por sitio | Control centralizado por sitio |

| Híbrido borde-nube | Solo embeddings/thumbnails (KB/consulta) | El borde embebe + ANN fragmentado en la nube | Escala de millones | Equilibrado: uplink minimizado + política central |

| Solo en nube | Recortes/cuadros; 2–8 Mbps por flujo de 1080p continuo | GPUs/CPUs elásticas | De millones a billones | Centralizado; mayor riesgo de privacidad sin minimización |

Análisis de Sensibilidad Financiera

Utilización

- A medida que la utilización aumenta hacia 24/7, los costos solo en nube escalan con la ingestión continua; el ancho de banda y el egreso crecen en elementos de línea dominantes. Edge e híbrido amortizan CapEx y mantienen OpEx estable, mejorando el costo por inferencia con el tiempo.

- Para ciclos de trabajo bajos o uso intermitente, solo en nube sigue siendo atractivo porque el gasto en computación se alinea con el tráfico limitado y el CapEx es mínimo.

Crecimiento de listas de vigilancia

- Las galerías pequeñas se ajustan al edge y soportan el OpEx más bajo. Más allá de unos cientos de miles de identidades, el híbrido toma el control para evitar la presión de memoria en el edge y las cargas iniciales frías del índice. Permanecer solo en nube para galerías grandes es viable pero lleva consigo costos de ingestión continua.

Variabilidad de la red

- Los sitios con Wi‑Fi congestionado o enlaces ascendentes 5G variables se benefician del procesamiento centrado en edge. El híbrido tolera bien la variabilidad porque los embeddings son pequeños y resilientes al jitter; las arquitecturas de streaming sufren erosión del SLA y costo impredecible bajo las mismas condiciones.

Lista de Verificación de Decisión para Ejecutivos

- Tamaño de la galería:

- ≤100k: favorece en el dispositivo o cerca del edge por el menor ancho de banda y latencia.

- ≥1M: favorece híbrido con ANN en la nube fragmentado y cachés de edge.

- Concurrencia:

- Muchas cámaras siempre activas: evita el streaming; elige edge o híbrido.

- Tráfico intermitente/pilotos: considera solo en nube por agilidad y bajo costo inicial.

- Política y jurisdicción:

- Regímenes estrictos de privacidad o entornos sindicalizados: prioriza la minimización de datos a través de edge-first o híbrido con enlace ascendente de solo embedding.

- Sitios de alta seguridad: aplica PAD en el dispositivo; asegura cifrado en reposo y robustas pistas de auditoría.

- Red:

- WAN no confiable o costosa: decisiones solo en edge con almacenamiento y reenvío.

- Redes gobernadas con PoPs regionales: híbrido para SLAs ajustados y búsqueda a escala de millones.

- Operaciones:

- TI limitada en sitio: consolidación cerca del edge para simplificar el mantenimiento.

- SOC centralizado: híbrido con puntos de presencia regionales y controles claros de egreso.

Conclusión

La economía de la identificación biométrica en tiempo real ha cambiado de flops a flows. Mover la detección y el embedding al edge y enviar solo vectores compactos a la nube reduce el ancho de banda por 100× o más, convirtiendo las facturas de red impredecibles en centavos manejables mientras se preservan SLAs rápidos y confiables. Para sitios multi-cámara constantes, esa es la diferencia entre un TCO viable y un Opex desenfrenado. Para galerías a escala de un millón de IDs y análisis entre sitios, las arquitecturas híbridas preservan esos beneficios mientras entregan búsqueda elástica fragmentada y gobernanza consistente. Solo en nube aún brilla para pilotos de corta duración y programas de bajo ciclo de trabajo, pero sus costos de egreso e ingestión en estado estable se acumulan rápidamente en producción.

Puntos clave:

- El ancho de banda es la palanca: el enlace ascendente de solo embedding reduce la transferencia de datos por órdenes de magnitud frente al video en streaming.

- Edge o híbrido gana para sitios multi-cámara siempre activos; solo en nube se adapta a cargas de trabajo intermitentes y de corta duración.

- Las galerías a escala de millones apuntan al híbrido—con PoPs regionales y cachés de edge—para rendimiento y costo equilibrados.

- La minimización de datos es tanto una estrategia de cumplimiento como una estrategia de costos.

- La adquisición debe priorizar la división edge-cloud, búsqueda fragmentada y términos claros de egreso.

Próximos pasos:

- Cuantificar el ancho de banda por sitio usando 1080p30 a 2–8 Mbps por flujo como línea base, luego modelar volúmenes de embedding híbrido.

- Mapear el crecimiento de la galería durante 12–36 meses para anticipar cuándo se vuelve necesario el híbrido.

- Alinear la arquitectura con la gobernanza: DPIAs, retención, postura PAD y operaciones de derechos del sujeto.

- Piloto en uno o dos sitios con enfoque en edge, luego integrar búsqueda híbrida y PoPs regionales a medida que las listas de vigilancia y la concurrencia escalan.

Las organizaciones que hacen del ancho de banda un métrico de primera clase—y arquitectan para ello—realizarán despliegues más rápidos, gobernanza más limpia y TCO materialmente más bajo a medida que la biometría pasa de pilotos a producción a gran escala.