Las Tuberías de Identificación Facial en el Borde ofrecen Decisiones en 15–40 ms y 30–120 FPS en 2026

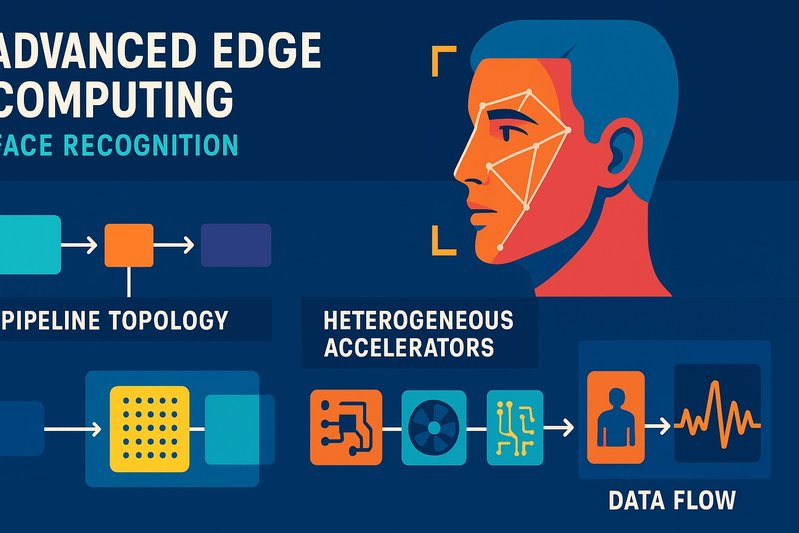

Una nueva generación de tuberías de identificación facial en el borde está logrando tiempos de decisión entre 15 y 40 ms mientras mantiene de 30 a 120 FPS por flujo de cámara, redefiniendo lo que significa “en tiempo real” en el sitio de captura. Este cambio es impulsado por un ciclo de ingeniería ajustado: una topología de tubería refinada desde la decodificación hasta la decisión, el mapeo deliberado de las cargas de trabajo en aceleradores heterogéneos, estrategias de compresión que mantienen la precisión en FP16/INT8, y una búsqueda de vecino más cercano aproximado (ANN) ajustada para la localidad de memoria y caché. Al mismo tiempo, los diseños híbridos que mantienen las incrustaciones en el borde y dividen la búsqueda vectorial en la nube ahora mantienen márgenes de latencia ajustados dentro de un solo viaje de ida y vuelta sobre la WAN.

Esta pieza explica cómo se construyen y optimizan estos sistemas. Verás la tubería desglosada por etapas y arquitectura; las elecciones de detectores y reconocedores que funcionan en hardware de borde; cómo la cuantización, poda y destilación reducen la latencia sin comprometer la precisión; dónde ejecutar qué en GPU/NPU/TPU/DSP; cómo se comparan HNSW, IVF-PQ y ScaNN; y cómo alcanzar objetivos de rendimiento controlando el presupuesto energético. También cubriremos el diseño de memoria de índices, los escollos de arranque en frío y las tácticas que los equipos usan para mantener las decisiones ágiles.

Detalles de Arquitectura/Implementación

Topología de la tubería: desde la captura hasta la decisión

Las tuberías de borde convergen en una topología común optimizada para baja latencia y un rendimiento constante:

- Captura y decodificación: la decodificación vía hardware mediante bloques ISP/encoder mantiene baja la carga de la CPU y alimenta los fotogramas en la tubería con un búfer mínimo.

- Detección y alineación: detectores modernos como RetinaFace y variantes de YOLO afinadas para rostros ofrecen una detección robusta a través de posturas y oclusiones, seguida de alineación para estabilizar las incrustaciones posteriores.

- Inferencia de incrustación: los reconocedores basados en margen—ArcFace, MagFace, CosFace—generan incrustaciones de 112×112 con gran poder discriminatorio; las incrustaciones de calidad consciente de MagFace permiten el umbral dinámico y la normalización de puntuaciones para rendimiento de conjunto abierto bajo calidad de captura variable.

- Búsqueda y decisión ANN: la búsqueda vectorial alojada localmente o en la nube devuelve a los primeros k candidatos; la decisión aplica umbrales ajustados para FAR/FRR deseados, con puertas de calidad opcionales y detección de ataques de presentación (PAD) donde sea necesario.

flowchart TD

A[Captura y Decodificación] --> B[Detección y Alineación]

B --> C[Inferencia de Incrustación]

C --> D[Búsqueda y Decisión ANN]Topología de la tubería que ilustra el flujo desde la captura de fotogramas hasta la toma de decisiones, destacando procesos clave y optimizaciones para baja latencia y rendimiento constante.

La detección optimizada para el borde en estado cálido más la incrustación comúnmente se ejecutan en 10–25 ms en NPUs/GPUs capaces, con la búsqueda ANN local agregando aproximadamente 0.5–5 ms para galerías de 100k o menos cuando se ajustan con HNSW o IVF-PQ. Esto da rangos de captura a decisión de ~15–40 ms para fotogramas 720p/1080p de una sola cara, excluyendo la verificación de liveness si no está habilitada.

Presupuestos de latencia por arquitectura

- En el dispositivo y cerca del borde: Mantener todo el ciclo local evita por completo la WAN. Cerca del borde agrega aproximadamente 1–2 ms sobre LAN. En estado cálido, 15–40 ms es típico por decisión a carga de una sola cara.

- Híbrido: El borde realiza detección/incrustación, la nube maneja la búsqueda vectorial. Agrega un viaje de ida y vuelta por WAN—frecuentemente 10–80 ms en entornos Wi‑Fi/5G eMBB comerciales—más búsqueda ANN en la nube (a menudo 2–15 ms en FAISS con GPU) y una ligera sobrecarga del intermediario. El extremo a extremo se ubica alrededor de 30–120 ms, dependiendo del RTT y la localidad de caché.

- Solo nube: Toda la tubería se ejecuta de forma remota; el enlace ascendente y la orquestación introducen 50–150+ ms en geografías típicas con colas bajo congestión o saltos entre regiones.

Los costos de arranque en frío importan. La carga de modelos en el borde frecuentemente agrega 100–500 ms; mapear índices de varios cientos de MB desde el disco puede agregar segundos. Persistir servicios, índices mapeados en memoria y precalentamiento reduce los retrasos de la primera decisión.

Opciones de detectores y reconocedores afinadas para el borde

- Detectores: RetinaFace sigue fuerte bajo oclusión y extremos de postura; las variantes ligeras de YOLO adaptadas para rostros ofrecen un alto rendimiento tras el ajuste específico de la tarea. La elección es un intercambio entre precisión/cálculo: las columnas vertebrales más grandes mejoran el recuerdo/precisión pero amplifican la latencia; los despliegues en el borde se apoyan en operadores fusionados y columnas vertebrales cuantificadas para mantenerse dentro del presupuesto.

- Reconocedores: ArcFace y CosFace son pilares para la identificación 1:N. Las incrustaciones de calidad consciente de MagFace ayudan a calibrar umbrales de conjunto abierto y normalización de puntuaciones, mitigando falsas aceptaciones bajo una captura deficiente. La optimización FP16 es efectivamente sin pérdidas; la INT8 bien calibrada generalmente se mantiene dentro de ~0–1% de precisión de reconocimiento FP32, preservando los márgenes de rendimiento de NIST cuando los umbrales se ajustan en datos objetivo.

Cuantización, poda y destilación

- Cuantización: FP16 es el predeterminado en el borde de clase GPU; INT8, cuando se calibra con datos representativos y escalas por tensor, reduce la latencia y la energía mientras mantiene la precisión en la mayoría de las tuberías.

- Poda y destilación: Aplicadas con juicio, comprimen modelos y reducen el ancho de banda de memoria. Una poda demasiado agresiva o una incompatibilidad de dominio pueden inflar el FRR—recalibra umbrales post-optimización y valida en datos de dominio para evitar regresiones.

- Soporte de tiempo de ejecución: TensorRT, ONNX Runtime, Core ML y NNAPI fusionan ops, programan kernels y mapean capas a aceleradores, reduciendo la sobrecarga de lanzamiento y mejorando la localidad de caché.

Utilización de aceleradores y coordinación de la CPU

- Qué ejecutar dónde:

- GPU/NPU/TPU/DSP: columnas vertebrales convolucionales, bloques de atención y operaciones de matriz grandes para detección y reconocimiento.

- CPU: entrega de decodificación de video, seguimiento/asociación, preprocesamiento ligero y búsqueda si se usa HNSW orientado a CPU. También orquesta las etapas de la tubería y maneja la I/O.

- Programación y fusión: Los tiempos de ejecución de los vendedores consolidan kernels y minimizan el tráfico de DRAM; en SoCs móviles (Snapdragon, Apple ANE), los programadores NNAPI/Core ML enfocan los aceleradores dedicados para mantener los márgenes de potencia bajos mientras sostienen tuberías de 30–60 FPS en tiempo real.

- Coordinación multiacelerador: En hardware de clase Jetson Orin/Xavier, las GPUs CUDA y las DLAs dividen las cargas de trabajo; TensorRT gestiona la ubicación de capas y la precisión. En Coral Edge TPU, los gráficos solo INT8 emparejados con HNSW del lado de la CPU ofrecen tuberías de extremo a extremo responsivas en galerías modestas.

Diseño de memoria e índices

- Dimensionalidad y precisión de incrustación: Una incrustación de 512‑D consume aproximadamente 2 KB en FP32, ~1 KB en FP16, ~512 B en INT8. Para 100k identidades, la memoria varía de ~50–200 MB dependiendo de la precisión y los metadatos del índice.

- Opciones de índice: IVF-PQ comprime vectores en códigos productamente cuantizados compactos para eficiencia de memoria e investigación amigable con cachés a escala; HNSW proporciona un alto recuerdo con latencias de CPU de sub-milisegundos y inserciones incrementales; ScaNN está optimizado para tiempos de consulta de alto recuerdo en CPUs/TPUs.

- Restricciones y cachés del borde: Las puertas de enlace de gama más alta alojan alrededor de ~100k a unos pocos cientos de miles de vectores en memoria sin compresión intensa; más allá de eso, la búsqueda híbrida con índices en la nube fragmentados y cachés de borde para identidades recientes evita la presión de RAM y largas cargas de arranque en frío.

Ingeniería de rendimiento y escalado de múltiples flujos

El rendimiento sostenido depende del tamaño del detector, la agrupación, y el control:

- Perfiles por dispositivo:

- Clase Jetson Orin con TensorRT: 30–120 FPS por flujo 1080p, escalando a cientos de FPS a través de múltiples flujos con agrupación.

- NPUs Snapdragon y Apple ANE: tuberías en tiempo real de 30–60 FPS en márgenes de potencia móviles, con margen para seguimiento/PAD cuando los operadores están fusionados y programados en aceleradores dedicados.

- Coral Edge TPU: 20–60 FPS por flujo en detectores de clase MobileNet cuantificados más reconocedores de clase MobileFaceNet, emparejados con HNSW de CPU para galerías modestas.

- VPUs Intel Myriad X: decenas de FPS por stick; las puertas de enlace frecuentemente agrupan varios para capacidad a nivel de sitio.

- Control y paralelismo: Los rastreadores por flujo reducen la detección redundante; los detectores en lotes a través de flujos para eficiencia GPU; el paralelismo de tuberías superpone decodificación, detección, incrustación y búsqueda; aísla hilos de búsqueda vinculados a CPU si se usa HNSW para prevenir el bloqueo de clientes prioritarios.

Energía por inferencia y rendimiento/W

- Coral Edge TPU: ~2 W de operación; inferencia INT8 con energía por inferencia en el rango de unos pocos milijulios para modelos de clase MobileNet.

- Jetson Orin NX: modos configurables de ~10–25 W; menos de 100 mJ por inferencia 112×112 en cargas de trabajo reales a 10–20 W, mientras se sostiene de decenas a cientos de FPS dependiendo del tamaño de los modelos.

- SoCs móviles (NPU Snapdragon, Apple ANE): tuberías de 30–60 FPS a unos pocos vatios con gestión de energía dinámica; los programadores de plataforma minimizan la energía por inferencia al aprovechar aceleradores dedicados.

- Solo nube: desplaza la energía fuera del sitio, mientras los ahorros en el borde crecen al evitar la codificación/carga continua.

Comportamiento de arranque en frío y mitigaciones

- Costos: carga del modelo 100–500 ms; mmap de índice segundos para galerías más grandes.

- Mitigaciones: servicios siempre activos y persistentes; precalentamiento al iniciar; índices mapeados en memoria; códigos PQ jerárquicos; calentamiento escalonado de cachés para ID recientes; inserciones de enrolamiento en micro-lotes.

- Enrolamiento: generación de incrustaciones de una sola identidad en <5–20 ms en aceleradores capaces; el extremo a extremo suma (incluso inserción de índice) a menudo cae en ~10–50 ms, mejorado aún más con agrupación.

Tablas de Comparación

Estrategias ANN de un vistazo

| Estrategia | Colocación típica | Fortalezas | Intercambios | Actualizaciones incrementales | Huella de memoria |

|---|---|---|---|---|---|

| HNSW | CPU de borde/CPU de puerta de enlace | Alto recuerdo a baja latencia de CPU; implementación simple | Limitado por CPU; la memoria crece con los enlaces | Sí, inserciones rápidas | Mayor sobrecarga por vector frente a esquemas comprimidos por PQ |

| IVF‑PQ (FAISS) | GPU/CPU de borde; GPU/CPU de nube | Códigos eficientes en memoria; amigable con cachés; aceleración GPU; escala de mil millones con fragmentación | La cuantización introduce una pequeña pérdida de recuerdo; requiere ajuste de nlist/nprobe | Sí | Muy compacto con PQ; metadatos del índice suman sobrecarga |

| ScaNN | CPU de borde; CPU/TPU de nube | Tiempos de consulta de alto recuerdo en CPUs/TPUs | Ecosistema más reducido que FAISS en algunas pilas | Sí | Eficiente; los detalles varían por configuración |

Perfiles de latencia y ancho de banda de arquitectura

| Arquitectura | Detección + Incrustación | Búsqueda ANN | Tránsito en red | Extremo a extremo (cálido) | Carga de enlace ascendente |

|---|---|---|---|---|---|

| En dispositivo | ~10–25 ms | ~0.5–5 ms (≤100k) | Ninguno | ~15–40 ms | Solo alertas/metadatos |

| Cerca del borde | ~10–25 ms | ~0.5–5 ms (≤100k) | LAN +1–2 ms | ~17–45 ms | Solo alertas/metadatos |

| Híbrido borde-nube | ~10–25 ms (borde) | ~2–15 ms (nube) | WAN + serialización ~10–80+ ms | ~30–120 ms | Incrustaciones (KB/consulta) |

| Solo nube | N/A (remoto) | Lado nube | WAN + orquestación | ~50–150+ ms | Fotogramas o recortes de rostros |

Mapeo de aceleradores y roles

| Carga de trabajo | GPU/NPU/TPU/DSP | CPU | Notas |

|---|---|---|---|

| Decodificación/codificación | Bloques ISP/encoder | Orquestación | Las unidades de hardware minimizan la carga de CPU |

| Detección | Sí | Recurso alternativo | Las variantes de RetinaFace/YOLO se benefician de ops fusionadas y FP16/INT8 |

| Alineación | Sí (fusionado) | Sí (ligero) | A menudo núcleos fusionados/de preprocesamiento |

| Incrustación | Sí | Recurso alternativo | ArcFace/MagFace/CosFace en FP16/INT8 con escalas calibradas |

| Búsqueda ANN | GPU (FAISS), TPU (ScaNN), CPU (HNSW) | Sí | La elección está impulsada por el tamaño de la galería y objetivos de recuerdo/latencia |

| Seguimiento/PAD | Sí (donde se admite) | Sí | Mantiene el PAD colocado, si la latencia lo permite |

Mejores Prácticas

Topología de la tubería y control

- Controla la detección con rastreadores por flujo para reducir la computación redundante; promueve rastros faciales estables y agrega temporalmente para robusta identificación en escenarios no cooperativos.

- Normaliza los rostros a través de la alineación; rechaza recortes de baja calidad con puntuaciones de calidad al estilo MagFace para estabilizar umbrales de conjunto abierto.

Optimización del modelo y preservación de la precisión

- Considera FP16 como predeterminado en el borde de clase GPU; calibra INT8 usando datos de dominio objetivo y escalas por tensor para mantener la precisión de reconocimiento dentro de ~0–1% de FP32.

- Aplica poda y destilación cuidadosamente; vuelve a ajustar puntos de operación (FAR/FRR) después de cada paso de compresión y valida en conjuntos de datos específicos de dominio para evitar desviaciones.

- Fusiona operadores vía TensorRT/ONNX Runtime/Core ML/NNAPI para reducir la sobrecarga de lanzamiento de kernel y el tráfico de DRAM.

Colocación de aceleradores y programación

- Mapea columnas vertebrales convolucionales y operaciones lineales pesadas en GPU/NPU/TPU/DSP; mantén la CPU para orquestación, seguimiento, y HNSW si se selecciona.

- En SoCs multiacelerador (Jetson Orin/Xavier), explota las DLAs para la descarga y mantiene las SMs CUDA alimentadas con cargas de trabajo de detectores en lotes.

- En SoCs móviles, confía en NNAPI/Core ML para colocar ops en aceleradores dedicados y mantener el rendimiento en tiempo real a unos pocos vatios.

Diseño de índice ANN e higiene de memoria

- Para galerías de ≤100k, HNSW en CPU a menudo cumple con la latencia con alto recuerdo y actualizaciones incrementales simples.

- Para galerías más grandes o presupuestos de memoria más ajustados, IVF‑PQ en FAISS comprime las incrustaciones en códigos PQ y mantiene los datos de prueba residentes en caché; ajusta nlist/nprobe para tus objetivos de recuerdo/latencia.

- En despliegues híbridos, manten un caché de borde de identidades recientes; fragmenta y replica índices en la nube; indices PQ en memoria para minimizar el tiempo de espera del arranque en frío.

Ingeniería de rendimiento y escalado de múltiples flujos

- Agrupa fotogramas a través de flujos para la eficiencia del detector en GPUs; escalona tuberías por flujo para mantener una ocupación constante del dispositivo.

- Aísla hilos de CPU para la búsqueda HNSW para evitar la contención con decodificación/seguimiento; usa colas sin bloqueo entre etapas donde sea posible.

- En Coral Edge TPU y Myriad X, elige arquitecturas compatibles con INT8 (MobileNet-SSD, MobileFaceNet-class) y verifica la compatibilidad del operador para evitar retrocesos silenciosos a CPU.

Energía y modos de consumo

- En Jetson Orin NX, selecciona modos de potencia alrededor de 10–25 W para balancear el rendimiento con el margen térmico; apunta a menos de 100 mJ por incrustación en operación sostenida.

- En SoCs móviles, deja que los programadores de plataforma mantengan la NPU/ANE caliente y las CPUs frías; evita copias de memoria innecesarias que inflan la energía por inferencia.

- En el borde, evita la carga de video continua; el enlace ascendente solo de incrustaciones del híbrido amortigua la energía a través de decisiones en lugar de fotogramas.

Arranque en frío y enrolamiento

- Precalienta modelos al inicio; indices grandes en memoria; programa toques suaves periódicos para prevenir la expulsión de páginas.

- Mantén el enrolamiento liviano: genera incrustaciones en <5–20 ms en aceleradores admitidos; inserciones por lotes en HNSW o IVF‑PQ para 10–50 ms de enrolamiento de extremo a extremo por identidad.

- Para puertas de enlace, programa cargas de índice y prioriza el calentamiento de fragmentos recientes; expón métricas de estado que reflejen la preparación del índice para evitar decisiones en trayectorias frías.

Toma de decisiones y umbrales

- Configura puntos de operación explícitamente para FAR/FRR deseados; usa incrustaciones de calidad consciente para modular umbrales bajo condiciones de captura deficiente.

- En configuraciones híbridas, incluye lógica ligera de intermediario para aciertos de caché antes de consultas en la nube; limita los reintentos bajo fluctuación de la WAN para mantener los SLAs intactos. ⚙️

Conclusión

La identificación facial en el borde ahora está diseñada, no esperada: con detectores y reconocedores optimizados en FP16/INT8, búsqueda ANN afinada, y mapeo disciplinado de aceleradores, las decisiones llegan en 15–40 ms en el dispositivo y cerca del borde, con un rendimiento en tiempo real de 30–120 FPS por flujo. Los diseños híbridos extienden esos beneficios a galerías de millones, intercambiando un único viaje de ida y vuelta por WAN por capacidad de búsqueda elástica mientras mantienen las cargas de enlace a unos pocos kilobytes. Los escollos restantes—arranques en frío, presión de memoria y picos de energía—son problemas que se resuelven cada vez más cuando los equipos precalientan modelos, índices en memoria, y controlan tuberías con rastreadores y puntuación de calidad.

Puntos clave:

- Mantén la detección y la incrustación en el sitio de captura; reserva la capacidad de la nube para búsqueda y análisis fragmentados cuando las galerías superen la RAM del borde.

- Considera FP16 como el predeterminado e INT8 como un objetivo de primera clase con calibración; vuelve a ajustar umbrales después de cualquier paso de compresión.

- Elige ANN según la escala: HNSW para galerías modestas en el borde; IVF-PQ para escala comprimida y aceleración GPU; ScaNN para rutas de alta recuperación en CPU/TPU.

- Diseñe el rendimiento, no lo asuma: agrupe detectores, paralelice tuberías y fije hilos de búsqueda CPU-bound.

- Precalienta agresivamente y indices en memoria para neutralizar la latencia de arranque en frío.

Próximos pasos: perfila tu tubería actual etapa por etapa; calibra INT8 en datos de dominio; realiza una prueba A/B entre HNSW e IVF‑PQ con tus incrustaciones y objetivos de recuperación; e implementa el control de rastreadores y la programación por lotes en el acelerador de tu elección. Al abordar la identificación en el borde como un problema de rendimiento de tubería completa, cumplirás consistentemente con SLA de menos de 50 ms—y los sostendrás a medida que crezcan las galerías y el conteo de cámaras. 🚀