Arnés Herramienta Determinista para MatchTIR: Esquemas JSON, Controladores LangGraph y Telemetría Reproducible

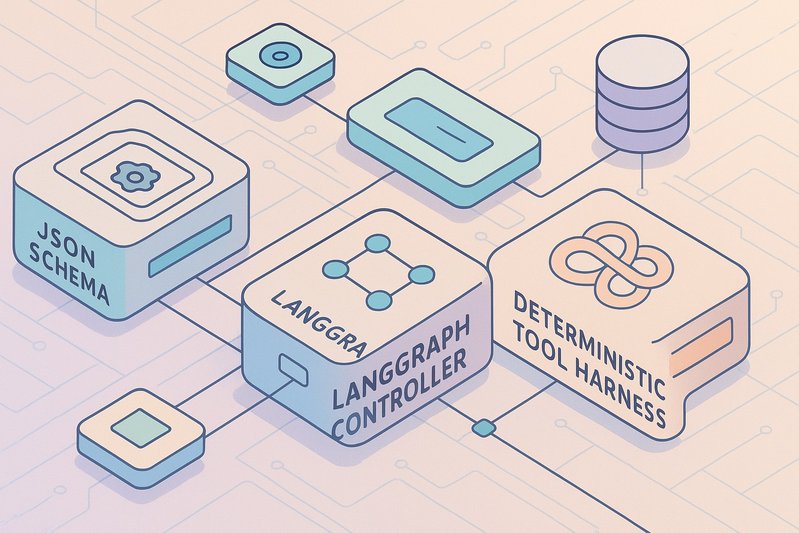

Cuando los sistemas de IA que utilizan herramientas tropiezan, el culpable a menudo no es el razonamiento del modelo, sino la infraestructura a su alrededor: enrutamiento de herramientas, orquestación y avisos. Para MatchTIR, atribuir victorias y derrotas al componente correcto requiere un arnés que normalice interfaces, aísle controladores y mida todo lo que importa. Este artículo presenta un esquema de evaluación concreto y determinista que expone el verdadero perfil de rendimiento de MatchTIR sin confusiones. Aprenderás cómo las interfaces de herramientas basadas en Esquema JSON se alinean con las APIs principales de llamadas a funciones; cómo los controladores LangGraph intercambiables separan la orquestación de la capacidad del modelo; cómo los entornos fijados, cassettes de repetición y la procedencia hacen que las ejecuciones sean repetibles; y cómo la telemetría exhaustiva permite rigor estadístico y análisis de errores accionables.

Detalles de Arquitectura/Implementación

Normalización de interfaces a través de Esquemas JSON

La normalización de interfaces se encuentra en el núcleo del arnés. Todas las herramientas—calculadoras, ejecución de Python, recuperadores, navegadores, motores SQL, y APIs externas—se exponen a través de firmas de funciones Esquema JSON alineadas con la llamada a funciones de OpenAI y convenciones de uso de herramientas de Anthropic. Esta estandarización minimiza el sesgo inducido por el esquema, permite una validación estricta de argumentos y hace que la precisión y el recall por herramienta sean medibles contra bases de referencia de llamadas a funciones supervisadas como ToolBench y Gorilla OpenFunctions.

El registro de llamadas a herramientas captura tanto los resultados sintácticos como semánticos para cada acción: qué herramienta seleccionó el modelo, si los argumentos coincidieron con el esquema, si la llamada se ejecutó exitosamente, y cómo cambió la puntuación de la tarea posterior. Este registro permite el cálculo de precisión/recall de llamadas a herramientas, corrección de argumentos y tasas de llamadas inválidas y de reintentos, que la literatura indica son decisivos para el éxito de extremo a extremo.

Controladores intercambiables como gráficos y cadenas

Los controladores se representan en dos abstracciones equivalentes:

- Orquestadores basados en gráficos (LangGraph) para planificación desacoplada, razonamiento-actuación intercalada, y separación planificador-ejecutor.

- Cadenas lineales (LangChain) para replicar pautas canónicas bajo menús y presupuestos idénticos.

Bajo este esquema, la misma tarea puede ser ejecutada por un intercalado al estilo ReAct, una estrategia de planificarse primero en el espíritu de ReWOO, una búsqueda multirama deliberada similar a Árbol-de-Pensamiento, o un controlador que integra autorreflexión para reparar errores en horizontes más largos, todo sin cambiar descripciones de herramientas o temperatura de decodificación. Cuando MatchTIR se conecta, cualquier mejora medida sobre estos controladores canónicos refleja su lógica de orquestación y no diferencias de interfaz confusas.

Determinismo, aislamiento y repetición

La repetibilidad no es negociable. El arnés impone determinismo y aislamiento mediante:

- Ejecución de Python y SQL en imágenes Docker con semillas fijas y cuotas de recursos.

- Evaluación de tareas de navegación en arenas estandarizadas (WebArena, BrowserGym) con ejecuciones estáticas en caché para repetición exacta y variantes en vivo etiquetadas para cuantificar la variación del mundo real.

- Fijación de pipelines de recuperación (corpora e implementaciones de índices) y requerimiento de que los recuperadores expongan procedencia, de modo que el arnés pueda calificar la fundamentación en lugar de solo la precisión de la forma superficial usando diagnósticos BEIR y RAGAS.

- Uso de cassettes de repetición estilo VCR como predeterminados para APIs externas para capturar cargas útiles de petición/respuesta y comportamiento de limitación de tasa.

- Aprovisionamiento de contenedores Postgres/MySQL versionados para Spider y BIRD con límites de privilegios estrictos y registros de consultas auditados.

Telemetría y rigor estadístico

La capa de telemetría es exhaustiva por diseño: cada turno registra indicaciones (sistema y usuario), los esquemas de herramientas expuestos al modelo, el gráfico de llamadas a herramientas, argumentos y respuestas, decisiones de controladores, conteos de tokens (desglosados por pensamiento vs. cargas útiles de herramientas), y descomposición de latencia en tiempo de pensamiento y tiempo de herramienta. Al repetir ejecuciones a través de semillas, el arnés admite pruebas de significación emparejadas para resultados de tareas y análisis tipo Wilcoxon para latencia y costo. Todos los resultados siguen divulgaciones estilo HELM para configuraciones y trazas que apoyan replicación externa.

Cobertura de benchmark para exponer diferentes modos de falla

Para tensionar significativamente la pila, el arnés cubre:

- Razonamiento programático: calculadora + Python en sandbox; compara razonamiento asistido por programa (PAL) y ramificación deliberada (ToT) para exponer compromisos entre precisión–latencia.

- Ingeniería de software: SWE-bench bajo pilas de desarrollador reproducibles (editor, shell, pruebas) y líneas base de agentes como OpenDevin/OpenHands para capturar efectos de orquestación, donde a menudo la fidelidad del entorno domina.

- Navegación: WebArena y BrowserGym para navegación y llenado de formularios con métricas estandarizadas; las páginas adversarias exponen la fragilidad de inyección de avisos.

- Texto a SQL: Spider y BIRD con instantáneas de bases de datos versionadas y precisión de coincidencia exacta vs. ejecución para sondear exposición de esquemas y límites de seguridad.

- QA multi-hop y planificación: HotpotQA y MuSiQue para razonamiento composicional con RAG; AgentBench y GAIA para una planificación más amplia con APIs estandarizadas.

Tablas Comparativas

Paradigmas de controladores bajo menús y presupuestos de herramientas idénticos

| Controlador | Idea central | Fortalezas (evidencia) | Efecto en costo/latencia | Dónde sobresale |

|---|---|---|---|---|

| ReAct | Intercalar razonamiento y actuación | Fuerte por defecto en entornos interactivos | Posiblemente mayor conteo de llamadas a herramientas | Navegación, herramientas de múltiples pasos |

| ReWOO/planificarse primero | Desacoplar planificación de observación | Recorta llamadas innecesarias mientras preserva precisión | Menor costo a precisión similar | Tareas con herramientas costosas |

| Árbol-de-Pensamiento | Ramificación/búsqueda deliberada | Mayor precisión en matemáticas/codificación | Aumento de tokens y latencia p95 | Razonamiento complejo, código |

| Reflexión | Autorreparación iterativa | Mejora el éxito a largo plazo con sobrecarga modesta | Turnos y tokens adicionales | Agentes de múltiples turnos |

Las métricas comparativas específicas dependen de la tarea y la configuración; el arnés informa métricas de éxito oficiales por dominio con intervalos de confianza (métricas específicas no disponibles) [11–15][19–21][23–26].

Componentes del arnés, palancas de determinismo y métricas expuestas

| Componente | Palanca de determinismo/aislamiento | Métricas primarias expuestas |

|---|---|---|

| Interfaces de herramientas | Esquema JSON alineado a OpenAI/Anthropic | Precisión/recall de llamadas a herramientas, corrección de argumentos, tasa de inválidos/reintentos |

| Controladores | Gráficos LangGraph y cadenas LangChain | Cuenta/profundidad de llamadas, costo, deltas de éxito versus puntos de referencia |

| Python/SQL | Docker fijado, semillas, cuotas | Éxito de ejecución, desglose de latencia |

| Navegación | WebArena/BrowserGym, caché estática + etiquetas en vivo | Éxito/recompensa, varianza versus en vivo |

| RAG | Corpora/índices fijados; procedencia; BEIR/RAGAS | Fundamentación, fidelidad |

| APIs externas | Cassettes de VCR/repetición | Resultados de inyección de fallos, reintentos |

| Reportes | Configuraciones estilo HELM, CIs multi-seed | Pruebas emparejadas, latencia p50/p90/p99 |

Mejores Prácticas

- Normalizar temprano, validar siempre. Usa Esquema JSON para cada herramienta con validación de argumentos aplicada en el momento de la llamada. Alinéate con la llamada a funciones de OpenAI/Anthropic para reducir la deriva de esquemas y hacer que tu sistema sea portátil entre modelos y proveedores. Los conjuntos de datos de llamadas a funciones supervisadas (ToolBench/Gorilla) son referencias sólidas para precisión/recall y reducción de llamadas inválidas.

- Desacoplar la orquestación de la capacidad. Implementa controladores como gráficos intercambiables (LangGraph) y cadenas (LangChain) para que el enrutamiento y la planificación puedan ablacionarse independientemente del modelo subyacente. Mantén constantes los menús y presupuestos de herramientas a través de brazos para atribuir mejoras a la orquestación en lugar de la exposición.

- Haz del determinismo una función, no una esperanza. Fija imágenes Docker, semillas, corpora y bases de datos; prefiere repeticiones estilo VCR para APIs; y divide la navegación en cachés estáticas y ejecuciones en vivo etiquetadas para contar la varianza.

- Mide la fundamentación, no solo la precisión. En RAG y QA multi-hop, registra la procedencia de la evidencia y usa BEIR y RAGAS para calificar si las respuestas están respaldadas, no solo correctas en la forma superficial.

- Instrumenta para la ciencia. Captura indicaciones, esquemas, gráficos de llamadas a herramientas, tokens (razonamiento vs. carga útil de herramienta), y descomposición de latencia; adopta divulgación de configuración estilo HELM y pruebas emparejadas multi-seed para asegurar que las conclusiones son estadísticamente defendibles.

- Estrés para robustez y seguridad. Inyecta fallos, picos de latencia y cargas útiles malformadas; sirve páginas adversarias a los agentes; y categoriza incidentes bajo el Top 10 de OWASP LLM para cuantificar riesgos y comportamientos de recuperación.

- Prueba la generalización a través de familias de modelos. Ejecuta configuraciones de decodificación igualadas y límites de presupuesto a través de APIs de herramientas clase GPT-4, uso de herramientas Claude, modelos Llama 3.1 y la familia DeepSeek para revelar diferencias de portabilidad y eficiencia muestral (métricas específicas no disponibles).

💡 Trata el costo por éxito y la eficiencia muestral como objetivos de primera clase, no pensamientos posteriores; muchas elecciones de controladores intercambian precisión por latencia y tokens.

Ejemplos Prácticos

Aunque los detalles de implementación específicos de MatchTIR no están disponibles públicamente (métricas específicas no disponibles), el arnés admite los siguientes patrones de evaluación concretos extraídos de la literatura y puntos de referencia citados en el informe:

-

Compromisos de razonamiento programático. En tareas que requieren razonamiento aritmético o simbólico, expón tanto una calculadora como una herramienta Python en sandbox. Compara un enfoque asistido por programa estilo PAL contra una configuración multirama deliberada inspirada en Árbol-de-Pensamiento para cuantificar cuánto se gana en precisión al costo de tokens adicionales y latencia p95. Debido a que las interfaces están normalizadas y los argumentos validados, el arnés puede atribuir fallos a mala selección (calculadora vs. Python), errores de argumentos (incompatibilidades de esquema), o callejones sin salida del controlador.

-

SWE-bench con pilas de desarrollo reproducibles. Usa contenedores fijados y repositorios versionados para asegurar fidelidad del entorno. Evalúa MatchTIR junto a líneas base de agentes de software (OpenDevin, OpenHands) bajo herramientas de editor/shell/prueba idénticas. El arnés registra si los parches se compilan, si las pruebas pasan, y cómo las elecciones de controladores afectan la profundidad de llamadas a herramientas y los reintentos, un escenario donde la orquestación y la disciplina de herramientas a menudo dominan la calidad bruta del modelo.

-

Navegación en arenas estáticas y en vivo. Ejecuta WebArena y BrowserGym con páginas estáticas en caché para repetición exacta así como variantes en vivo etiquetadas para cuantificar la varianza. Inyecta páginas adversarias para medir la susceptibilidad a la inyección de avisos, recuperación, y adherencia a políticas; categoriza incidentes bajo el Top 10 de OWASP LLM. El gráfico de llamadas a herramientas y el desglose de latencia separan el “tiempo de pensamiento” del “tiempo de herramientas”, lo que permite ablaciones focalizadas de controladores (por ejemplo, planificarse primero vs. intercalado).

-

Texto a SQL bajo límites de privilegios. Evalúa Spider y BIRD contra instantáneas Postgres/MySQL versionadas con privilegios estrictos y registros de consultas auditados. Mide tanto la precisión de coincidencia exacta como la de ejecución; usa ablaciones de controladores para probar si las estrategias de planificarse primero reducen las sobrellamadas (por ejemplo, sondeos innecesarios de esquemas) sin perjudicar la precisión. Las trazas repetibles permiten a los revisores etiquetar fallos como errores de argumentos, selección incorrecta de tablas, o uso inseguro de herramientas.

-

QA multi-hop con comprobaciones de fundamentación. Acopla HotpotQA y MuSiQue con herramientas RAG que registran evidencia clasificada y procedencia. Califica la fidelidad de la respuesta con BEIR/RAGAS y compara controladores ReAct vs. planificarse primero vs. ramificación deliberada para ver si un controlador que selecciona buenas herramientas también produce respuestas fundamentadas. La precisión/recall por herramienta del arnés revela si un selector consciente del esquema mejora la calidad de recuperación y reduce el uso ilusorio de herramientas.

Conclusión

Un arnés determinista, intercambiable y totalmente instrumentado convierte la evaluación de MatchTIR en una cuestión de evidencia, no de narración. Al normalizar interfaces de herramientas con Esquemas JSON, representar controladores como gráficos LangGraph y cadenas LangChain, imponer determinismo a través de entornos fijados y repeticiones, y registrar telemetría exhaustiva con rigor estilo HELM, los revisores pueden atribuir inequívocamente las mejoras al selector de herramientas, controlador o política de avisos. El resultado: ejecuciones comparables a través de semillas, modelos y revisores que exponen los verdaderos compromisos entre costo y precisión y perfiles de seguridad.

Puntos clave:

- La normalización de interfaces elimina el sesgo inducido por esquemas y permite medir la precisión/recall de llamadas a herramientas.

- Los controladores intercambiables aíslan los efectos de orquestación bajo menús y presupuestos de herramientas idénticos.

- El determinismo (contenedores fijados, cachés, cassettes) es esencial para resultados repetibles y análisis robusto de errores.

- La telemetría más los informes estilo HELM soportan pruebas emparejadas y conclusiones reproducibles.

- La robustez y la seguridad requieren pruebas de estrés sistemáticas y la taxonomía de incidentes alineada con OWASP.

Próximos pasos para los practicantes: implementa registros de herramientas Esquema JSON alineados a las convenciones de OpenAI/Anthropic; refactoriza controladores en gráficos LangGraph y cadenas LangChain; fija tus entornos y añade VCR para APIs; integra BEIR/RAGAS para fundamentación; y publica configuraciones y trazas estilo HELM. Hecho correctamente, verás exactamente dónde MatchTIR ayuda—y dónde necesita trabajar—a través de dominios y familias de modelos. 🚀

Fuentes

- ReAct: Sinergizando Razonamiento y Actuación en Modelos de Lenguaje — https://arxiv.org/abs/2210.03629 — Relevancia: Establece la base de referencia de razonamiento-actuación intercalada utilizada como controlador canónico.

- ReWOO: Desacoplando Razonamiento de Observaciones — https://arxiv.org/abs/2305.18323 — Relevancia: Apoya la orquestación de planificarse primero para reducir llamadas a herramientas innecesarias.

- PAL: Modelos de Lenguaje Asistidos por Programas — https://arxiv.org/abs/2211.10435 — Relevancia: Demuestra el razonamiento asistido por programas con ejecución de código en tareas de matemáticas/codificación.

- Árbol de Pensamientos: Resolución Deliberada de Problemas con Modelos de Lenguaje Grandes — https://arxiv.org/abs/2305.10601 — Relevancia: Motiva el razonamiento multirama deliberado y sus compromisos de costo/latencia.

- Reflexión: Agentes de Lenguaje con Aprendizaje por Refuerzo Verbal — https://arxiv.org/abs/2303.11366 — Relevancia: Proporciona evidencia para la autorreparación iterativa en tareas de más largo alcance.

- ToolBench (OpenBMB) — https://github.com/OpenBMB/ToolBench — Relevancia: Suministra bases de llamadas a funciones supervisadas para medir precisión/recall de llamadas a herramientas y tasas de llamadas inválidas.

- Gorilla: Modelo de Lenguaje Grande Conectado con Masivas APIs — https://arxiv.org/abs/2305.15334 — Relevancia: Muestra cómo los esquemas de API de alta calidad mejoran la corrección de argumentos y reducen las llamadas inválidas.

- Gorilla OpenFunctions (GitHub) — https://github.com/ShishirPatil/gorilla — Relevancia: Proporciona firmas de funciones estandarizadas para evaluar la calidad de llamadas a herramientas.

- AgentBench (arXiv) — https://arxiv.org/abs/2308.03688 — Relevancia: Evalúa tareas de múltiples API y planificación relevantes para la robustez del controlador.

- AgentBench (GitHub) — https://github.com/THUDM/AgentBench — Relevancia: Ofrece la implementación para APIs de agentes estandarizados y recompensas.

- WebArena (arXiv) — https://arxiv.org/abs/2307.13854 — Relevancia: Entorno de navegador estandarizado para medir navegación/rellenado de formularios.

- Sitio web de WebArena — https://webarena.dev — Relevancia: Recurso oficial para entornos y métricas.

- BrowserGym (arXiv) — https://arxiv.org/abs/2401.07317 — Relevancia: Proporciona un área de navegación controlada y métricas; apoya ejecuciones estáticas vs. en vivo.

- SWE-bench (arXiv) — https://arxiv.org/abs/2310.06770 — Relevancia: Benchmark de corrección de errores del mundo real donde la orquestación y la fidelidad del entorno importan.

- Sitio web/ranking de SWE-bench — https://www.swe-bench.com — Relevancia: Métricas oficiales y protocolos de reproducibilidad.

- OpenDevin (arXiv) — https://arxiv.org/abs/2407.12894 — Relevancia: Línea base de agente de software para comparar estrategias de orquestación en SWE-bench.

- OpenHands (arXiv) — https://arxiv.org/abs/2407.01489 — Relevancia: Alternativa de línea base de agente que enfatiza comparaciones de herramientas de desarrollo realistas.

- DS-1000 (arXiv) — https://arxiv.org/abs/2306.17565 — Relevancia: Sondea el uso de herramientas de ciencia de datos en Python, estresando el determinismo en sandbox.

- Spider (arXiv) — https://arxiv.org/abs/1809.08887 — Relevancia: Generalización de texto a SQL con métricas de precisión de ejecución y coincidencia exacta.

- BIRD (arXiv) — https://arxiv.org/abs/2305.03111 — Relevancia: Benchmark de texto a SQL a gran escala enfatizando la fundamentación realista de bases de datos.

- Clasificación de BIRD — https://bird-bench.github.io/leaderboard — Relevancia: Protocolo de evaluación oficial y métricas para precisión de ejecución.

- GAIA (arXiv) — https://arxiv.org/abs/2311.12983 — Relevancia: Benchmark de planificación/agente para probar la orquestación bajo diversas APIs.

- HotpotQA (arXiv) — https://arxiv.org/abs/1809.09600 — Relevancia: Conjunto de datos de QA multi-hop para razonamiento composicional + evaluación RAG.

- MuSiQue (arXiv) — https://arxiv.org/abs/2202.06643 — Relevancia: QA de múltiples pasos que enfatiza la composicionalidad.

- BEIR (arXiv) — https://arxiv.org/abs/2104.08663 — Relevancia: Evaluación de recuperación estandarizada para evaluar la calidad de la evidencia.

- RAGAS (GitHub) — https://github.com/explodinggradients/ragas — Relevancia: Métricas de fidelidad para la fundamentación RAG.

- HELM (arXiv) — https://arxiv.org/abs/2211.09110 — Relevancia: Recomienda configuraciones transparentes, ejecuciones multi-seed y reportes rigurosos.

- MiniWoB++ (arXiv) — https://arxiv.org/abs/1707.06150 — Relevancia: Micro-tareas para seleccionar fiabilidad en acciones de interfaz de usuario de grano fino.

- Documentación de LangChain — https://python.langchain.com/ — Relevancia: Orquestador de cadenas base utilizado para estandarizar controladores lineales.

- Documentación de Uso de Herramientas de Anthropic — https://docs.anthropic.com/en/docs/build-with-claude/tool-use — Relevancia: Define las convenciones de uso de herramientas que informan el alineamiento de Esquema JSON.

- Guía de Llamada a Funciones de OpenAI — https://platform.openai.com/docs/guides/function-calling — Relevancia: Establece las convenciones de esquemas de llamada a funciones para evitar sesgo de interfaz.

- Anuncio de Meta Llama 3.1 — https://ai.meta.com/blog/meta-llama-3-1/ — Relevancia: Indica soporte de llamada a funciones para evaluaciones de modelo de peso abierto.

- DSPy (arXiv) — https://arxiv.org/abs/2306.04031 — Relevancia: Motiva la optimización declarativa de indicaciones para reducir las llamadas inválidas.

- Top 10 de OWASP para Aplicaciones LLM — https://owasp.org/www-project-top-10-for-large-language-model-applications/ — Relevancia: Taxonomía estandarizada para reportar incidentes de seguridad en agentes.

- DeepSeek-LLM (arXiv) — https://arxiv.org/abs/2401.02954 — Relevancia: Familia de modelo abierto utilizada para probar la generalización de controladores entre modelos.

- Documentación de LangGraph — https://langchain-ai.github.io/langgraph/ — Relevancia: Orquestador basado en gráficos para componer controladores intercambiables.

- LlamaIndex — https://www.llamaindex.ai/ — Relevancia: Expone recuperadores como herramientas con procedencia para apoyar la puntuación de fundamentación.