Agentes Ambientales, Nubes de Borde Atestiguadas y Multimodalidad en el Dispositivo Establecen los Próximos Dos Años de IA Móvil

Una hoja de ruta de innovación para asistentes que preservan la privacidad, modelos conscientes de la energía y pilas adaptadas regionalmente

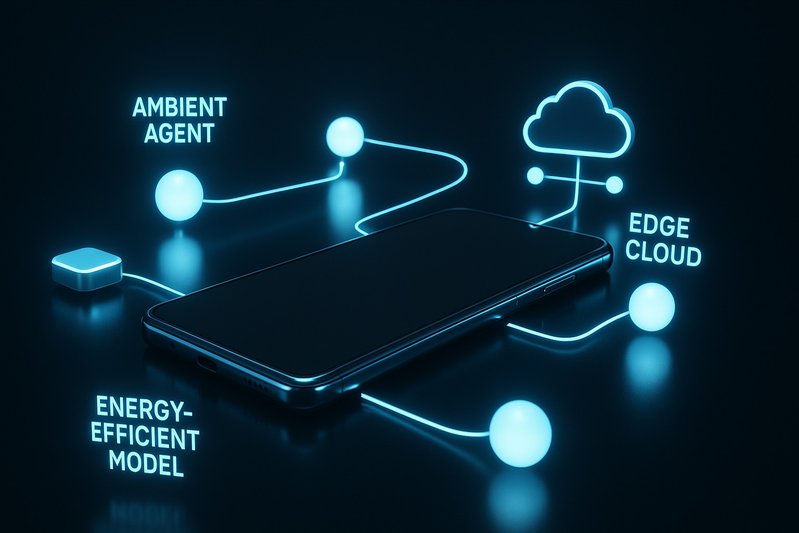

A principios de 2026, la IA en smartphones ha pasado de ser un complemento de funciones a convertirse en un tejido fundamental, especialmente en la gama premium, reformulando cómo los usuarios escriben, traducen, capturan y editan en todo el sistema. Los avances más visibles son materiales: asistentes que funcionan en varias aplicaciones, cámaras multimodales y canalizaciones de video, y comunicación en tiempo real que se mantiene aun cuando las redes fallan. Lo que ahora separa a los líderes no es tanto “quién tiene IA” sino “quién entrega experiencias confiables, primero en el dispositivo, con cobertura consistente de aplicaciones predeterminadas, una postura clara de privacidad y un comportamiento energético predecible”. Este artículo establece la hoja de ruta de innovación que definirá los próximos dos años: agentes ambientales con contexto persistente y garantías de privacidad, nubes de borde atestiguadas para descargas verificables más allá de una única plataforma, multimodalidad en el dispositivo dirigida a la comprensión en tiempo real de video y diseño centrado en la energía anclado por NPUs modernas. Los lectores aprenderán qué observar en las APIs de atestación, las trayectorias de MLPerf Mobile y los planes de desarrollo de NPU; qué patrones de UI generan confianza; cómo las pilas regionales divergen y convergen; y qué deben hacer los OEM ahora para ampliar la cobertura de asistentes sin agotar la batería o la buena voluntad del usuario.

Avances de Investigación

De función a tejido: asistentes que actúan en varias aplicaciones con contexto persistente y garantías de privacidad

Los asistentes a nivel de sistema están escapando de aplicaciones aisladas y actuando donde los usuarios ya trabajan. Apple Intelligence lleva herramientas de escritura—resumir, reescribir, corregir—integradas en iOS, con un Siri más capaz de contexto. En Android, Gemini está incrustado en múltiples capas, con Gemini Nano impulsando flujos de trabajo en el dispositivo como resúmenes en Recorder y respuestas inteligentes en Pixel 8 Pro. La IA Galaxy de Samsung convierte acciones entre aplicaciones en memoria muscular: Circle to Search funciona desde cualquier pantalla, Live Translate abarca llamadas y conversaciones en persona, y Note/Transcript Assist se encuentra con los usuarios en aplicaciones predeterminadas en lugar de pedirles que copien/peguen o cambien de aplicación.

flowchart LR;

A[Usuario] -->|usa| B[Apple Intelligence]

A -->|usa| C[Android Gemini]

B -->|proporciona| D[Herramientas de Escritura]

C -->|impulsa| E[Flujos de Trabajo en el Dispositivo]

B -->|interactúa con| F[Siri]

C -->|apoya| G[Respuestas Inteligentes]

H[Galaxy AI] -->|habilita| I[Circle to Search]

H -->|integra| J[Live Translate]

H -->|apoya| K[Note/Transcript Assist]Este diagrama de flujo ilustra las funcionalidades interconectadas de varios sistemas de IA y asistentes en diferentes plataformas, mostrando cómo los usuarios interactúan con estas tecnologías para mejorar la productividad e interacciones fluidas.

Las señales de privacidad ahora viajan con la capacidad. El modelo de Apple lidera: cuando las tareas exceden la capacidad en el dispositivo, Private Cloud Compute descarga a servidores verificados y endurecidos construidos con silicio de Apple, con atestación criptográfica y compromisos de transparencia. Samsung ancla la Galaxy AI dentro de su plataforma Knox, emparejando modos en el dispositivo para flujos de trabajo sensibles con controles de grado empresarial y almacenamiento seguro de claves respaldado por hardware. Google expone mensajes y configuraciones claros para diferenciar el manejo en el dispositivo de las funciones en la nube y se defiende con el sandboxing de Android. El patrón es claro: los asistentes deben ser a nivel de sistema y contextuales, pero su éxito se juzgará por cuán predeciblemente se mantienen locales, y cuán creíblemente lo prueban cuando la nube debe ayudar.

Asus destaca un hilo adyacente: el valor de una capacidad robusta fuera de línea. El Zenfone 12 Ultra integra un Meta Llama 3-8B en el dispositivo para la resumición y coloca todas las herramientas desarrolladas por Asus—escaneo de documentos, transcripción, resumen de artículos—para que funcionen localmente, con la nube opcional para trabajos pesados. La IA centrada en juegos del ROG Phone (X Sense, X Capture, AI Grabber) favorece el reconocimiento en el dispositivo para baja latencia. Esta postura local primero mitiga el riesgo diario de errores de “función fallida” en redes débiles mientras fortalece la privacidad por defecto.

Estandarizando la confianza: descarga atestiguada y computación verificable más allá de una única plataforma

La descarga verificable, que preserva la privacidad, ahora es un diferenciador competitivo, no un artículo de verificación. El Private Cloud Compute de Apple estableció un plano de alta garantía: ejecución fuera del dispositivo en entornos sellados y atestiguables en hardware controlado por el proveedor. Samsung y Google delinean robustas configuraciones predeterminadas en el dispositivo y controles de experiencia de usuario claros para cuando los datos de la red o de la cuenta fluyen. Los próximos dos años deberían empujar la computación atestiguada más allá de una única plataforma, con señales a nivel de API que cualquier aplicación o asistente pueda consultar: qué modelo se ejecutó, dónde se ejecutó y bajo qué atestación. Se espera que sectores empresariales y regulados demanden atestaciones portátiles y ganchos de política que abarquen sistemas operativos. La prueba no será la etiqueta de marketing, sino si los usuarios y administradores pueden verificar, predecir y auditar cómo los datos salen del dispositivo, si es que lo hacen.

Multimodalidad en el dispositivo: hacia la comprensión del video en tiempo real y el refinamiento generativo en el silicio del dispositivo

Las cámaras y las canalizaciones de video se están convirtiendo en motores semánticos en tiempo real. Pixel sigue combinando la semántica en el dispositivo con ediciones aceleradas en la nube como Magic Editor y Video Boost, dependiendo de las limitaciones de las funciones. Las Ediciones Generativas de Samsung y las características asistivas entre aplicaciones comprimen los pasos desde la captura hasta el pulido. Asus se inclina hacia los flujos de trabajo de creador en el dispositivo con AI Magic Fill, Unblur y Portrait Video 2.0, además de AI Tracking para estabilizar y enfocar la acción.

La trayectoria es hacia la realización de más de esto en vivo en el silicio del dispositivo. Las NPUs/APUs modernas y los schedulers, combinados con bibliotecas de operadores eficientes en energía, mueven ediciones de imágenes estáticas, resumición y traducción cómodamente en el dispositivo. El video generativo pesado sigue siendo un desafío: las ediciones largas pueden ser intensivas en energía y a menudo se difieren a canalizaciones en la nube. Pero el límite está cambiando a medida que mejora el rendimiento de inferencia en el dispositivo y las pilas de software co-programan ISP/NPU/GPU para evitar atascos. El objetivo pragmático en los próximos ciclos: reconocimiento en tiempo real y refinamiento generativo ligero localmente, con descarga atestada y transparente para las pocas tareas que aún exceden los límites térmicos y energéticos.

Hoja de Ruta y Direcciones Futuras

La energía como una restricción de primer nivel: qué se escala, qué espera

Las baterías y los térmicos definen el techo para la IA móvil. Métricas como MLPerf Mobile muestran mejoras de generación en generación en el rendimiento de inferencia y latencia, habilitando tareas interactivas en el dispositivo que anteriormente necesitaban la nube. Las divulgaciones de los proveedores sobre la capacidad y eficiencia de la NPU, junto con bibliotecas de operadores optimizadas, reducen la potencia por tarea. El resultado vivido: las ediciones de imágenes estáticas, la resumición de textos y la traducción tienen un impacto modesto en la batería en los silicios emblemáticos recientes, mientras que las ediciones de video generativo largo siguen siendo costosas.

Lo que sigue:

- Prioridad en el dispositivo, con aplazamiento inteligente: Mantener tareas cortas e interactivas localmente; poner en cola trabajos pesados, no urgentes, para descarga atestada o ventanas ociosas cuando estén conectados.

- Schedulers de sistema que traten la energía como un requisito del producto: Coordinar ráfagas de ISP/NPU/GPU para evitar precipicios térmicos que degraden la IA a mitad de tarea.

- Mejoras en modelos/herramientas centradas en la eficiencia energética: Continuar comprimiendo la potencia por token, cuadro y edición mediante avances en software y programación, incluso cuando las cargas de trabajo completas aún no pueden ser locales.

La estrella norte es la consistencia. Los usuarios perciben la confianza tanto a través de una latencia estable y un mantenimiento constante de la batería como a través de la velocidad pura, y juzgan la fiabilidad según si las características de la IA se completan de manera predecible en condiciones de señal deficiente.

Hitos para seguir: trayectorias de MLPerf Mobile, hojas de ruta de NPU, APIs de atestación

Una lista creíble de vigilancia incluye:

- Progreso de MLPerf Mobile: Rastrear cómo evoluciona la inferencia de clase dispositivo en tareas de texto y visión para inferir qué puede cambiar al dispositivo próximamente.

- Hojas de ruta de NPU: Nuevas olas de plataformas de clase Snapdragon 8 y clase Dimensity 9300 anclan el ritmo de características locales primero; las mejoras de capacidad a menudo llegan junto con schedulers más eficientes.

- APIs de atestación y privacidad: Observar señales a nivel de SO que informen a los usuarios y aplicaciones dónde se ejecutó una tarea y bajo qué garantías, construyendo sobre el estándar establecido por Private Cloud Compute.

Divergencia y convergencia regional: asociaciones locales LLM, cumplimiento, portabilidad entre fronteras

La amplitud de características aterriza cada vez más en todas partes, pero los back-ends son diferentes. HyperOS de Xiaomi integra funciones de asistente en cámaras, galerías y utilidades del sistema con programación del sistema ajustada para la eficiencia, mientras que la pila de cámaras del Xiaomi 14 Ultra impulsa la fotografía computacional con opciones de calidad profesional. ColorOS de Oppo integra borrador/edición de IA, ayudas de transcripción y resumisión, y motores de orquestación de recursos, y los asistentes regionales se adaptan a las regulaciones y expectativas locales. Las versiones para el mercado chino a menudo integran servicios nacionales para cumplir con los requisitos locales, buscando equivalencia en capacidades visibles para el usuario.

En América del Norte, Europa y Japón, las expectativas se inclinan hacia las historias de privacidad de Apple/Google/Samsung, el acabado de apps predeterminadas y señales amigables con empresas como Knox. La portabilidad entre fronteras importará más a medida que los viajeros y usuarios multinacionales esperen garantías de privacidad y rendimiento consistentes cuando los dispositivos se desplacen, un argumento para la estandarización de atestaciones y modos predecibles en el dispositivo independientemente del mercado. La convergencia es paridad funcional en tareas comunes como reescribir/resumir, traducir y editar fotos; la divergencia está en las garantías de privacidad, integraciones de servicios y cuán visiblemente se comunican esas garantías.

Impacto y Aplicaciones

Seguridad, confiabilidad y explicabilidad: patrones de UI que generan confianza

La confianza se gana mediante elecciones de diseño que los usuarios pueden sentir:

- Límites claros: Las herramientas de escritura integradas en iOS y Android hacen obvio cuándo el procesamiento es en el dispositivo versus cuándo invoca recursos en la nube, con mensajes y configuraciones que explican los compromisos.

- Modos predeterminados en el dispositivo: Live Translate en Samsung ofrece rutas de procesamiento local; los resúmenes del Recorder de Pixel se completan localmente en la mayoría de los casos, evitando momentos de “función fallida” en conectividad deficiente.

- Descarga atestada cuando sea necesario: El Private Cloud Compute de Apple declara explícitamente cuándo una tarea sale del dispositivo y bajo qué protecciones, cumpliendo con el estándar para usuarios sensibles a la privacidad y empresariales.

La explicabilidad en la IA móvil no requiere citas densas; exige un comportamiento predecible, estado visible y resultados recuperables. Si una característica no puede completarse localmente, debe decírselo, pedir permiso para descargar y devolver un resultado con el mismo perfil de latencia predecible. La confianza crece cuando los usuarios ven tiempos de culminación consistentes, entienden qué datos se mueven adónde y pueden optar por salir sin perder funcionalidad básica.

Medir lo que importa a continuación: confianza percibida por el usuario, estabilidad de latencia, previsibilidad de fallos

La velocidad y la precisión por sí solas ya no capturan la calidad de la UX. Una lente práctica es el marco “5-S”:

- Velocidad: Menos pasos y menos cambios de aplicación mediante asistencia entre aplicaciones.

- Tasa de éxito: Disponibilidad offline y degradación elegante reducen fallos en malas redes.

- Satisfacción: Cobertura en aplicaciones predeterminadas impulsa descubrimiento y hábito.

- Confianza en seguridad: Las garantías arquitectónicas—primero en el dispositivo, descarga atestada—anclan la confianza.

- Costo energético: Las tareas deben estar dentro de los presupuestos diarios de batería.

Para refinar esta lente, dos medidas complementarias importan:

- Estabilidad de latencia: No solo la velocidad mediana, sino la variación bajo carga, señal débil y estrés térmico.

- Previsibilidad de fallos: Estados claros cuando una tarea tendrá éxito offline versus diferirá, y alternativas inteligibles.

Las pruebas externas de batería en mezclas realistas proporcionan un contexto útil para la resistencia bajo uso de IA, aunque las cifras específicas varían según el dispositivo y la carga de trabajo. El objetivo para los próximos dos años: hacer que los resultados de la IA sean tan predecibles como tocar el obturador de la cámara—rápido, consistente, y con compromisos conocidos.

Hojas de ruta para los OEM: cobertura más amplia de aplicaciones predeterminadas, compromisos de ciclo de vida, amplitud de asistentes

Los próximos dos años recompensarán el detalle en la ejecución:

- Ampliar la cobertura de aplicaciones predeterminadas: Poner explicar/traducir/resumir donde los usuarios ya están—notas, teclado, cámara, teléfono, grabadora—reflejando cómo Galaxy AI y las herramientas de escritura a nivel de sistema de Apple impulsan el uso diario.

- Comprometerse con el local primero: Priorizar en el dispositivo para voz sensible a la privacidad y texto personal; reservar la descarga atestada para tareas pesadas aprobadas por el usuario.

- Enviar controles transparentes: Hacer que las elecciones entre el dispositivo y la nube sean explícitas y recordables, con ganchos de política empresarial donde sea relevante.

- Ajustar para los perfiles de usuario: Asus demuestra el poder del valor enfocado—resumición en el dispositivo orientada a creadores en Zenfone y reconocimiento crítico de latencia para juegos en ROG—mientras líderes como Apple, Google y Samsung muestran amplitud. Elija un centro de gravedad y ejecute profundamente.

- Ciclo de vida y estabilidad: Actualizaciones sostenidas que mejoren los modelos en el dispositivo y los schedulers después del lanzamiento pueden aumentar significativamente la velocidad, confiabilidad y energía sin nuevo hardware.

Riesgos y puntos de quiebre: errores de modelo, fallos de privacidad y agotamiento de batería

Tres líneas de falla probarán la madurez de la IA móvil:

- Salidas incorrectas o demasiado confiadas: Los sistemas generativos pueden producir resultados incorrectos o engañosos; las tasas específicas no están disponibles, así que diseñe para la verificación y el fácil retroceso.

- Grietas de privacidad en la descarga: Sin entornos verificados y controlados por el proveedor y divulgaciones claras, el procesamiento fuera del dispositivo erosiona la confianza, especialmente en contextos regulados.

- Batería y térmicos: Las ediciones de video generativo largo y otros trabajos pesados pueden llevar a los dispositivos al estrangulamiento térmico o al agotamiento visible; la UX práctica debe dirigirlos a la nube o ventanas ociosas, con elección explícita del usuario.

El camino resistente es mantener las tareas interactivas en el dispositivo, comunicar cuándo y por qué ocurre la descarga, y dar a los usuarios control sobre los compromisos de batería contra calidad.

Conclusión

La próxima fase de la IA móvil no se trata de invención en aislamiento; se trata de integración con garantías. Los asistentes están convirtiéndose de funciones en tejido—presentes en cualquier aplicación, llevando contexto y permaneciendo locales por defecto. Cuando los dispositivos deben buscar potencia adicional, las nubes de borde atestiguadas muestran cómo preservar la privacidad sin detener el progreso. Las cámaras y las canalizaciones de video continúan su deriva hacia la comprensión semántica en tiempo real en el dispositivo, delimitadas por realidades energéticas que los schedulers inteligentes y las NPUs en constante mejora relajan continuamente. Los ganadores medirán lo que los usuarios realmente sienten—confianza, estabilidad y resistencia—y diseñarán sus hojas de ruta alrededor de esos resultados.

Conclusiones clave:

- Los agentes ambientales necesitan contexto persistente y garantías de privacidad explícitas para ganar confianza diaria.

- La descarga atestada está pasando de diferenciador a expectativa; las APIs estandarizadas deberían seguir.

- La multimodalidad en el dispositivo se expandirá en texto, imagen y video de formato corto; las ediciones generativas pesadas siguen siendo candidatas para la nube.

- La energía es el reactivo limitante; diseñe para consistencia en latencia y estabilidad de batería, no solo velocidad máxima.

- Las pilas regionales convergerán en características pero divergirán en back-ends; la portabilidad de las señales de confianza importa.

Próximos pasos para constructores y compradores:

- Constructores: Priorizar cobertura de aplicaciones predeterminadas, predeterminados en el dispositivo y controles transparentes; invertir en rutas de atestación y ajustes de schedulers; seguir MLPerf Mobile y las hojas de ruta de NPU para planificar cambios de capacidad.

- Compradores: Buscar una arquitectura de privacidad clara, modos offline confiables y latencia consistente bajo condiciones reales; evaluar la amplitud del asistente donde realmente trabaja—notas, cámara, llamadas y grabadora.

Mirando hacia el futuro, observe tres diales: trayectorias de MLPerf Mobile para lo que permanece en el dispositivo, generaciones de NPU para qué tan rápido y eficiente se vuelve, y APIs de atestación para qué tan seguro fluye el resto. Si esos dials se mueven en concierto, los asistentes ambientales que preservan la privacidad se sentirán menos como una novedad y más como la forma predeterminada en que los teléfonos piensan y actúan. 🔋